一吨妈妈的回答

最行之有效的途径是拆解试卷。

虽然各个地市中考语文试卷具体内容各异,但除了占比越来越少的字音字形基础知识题外(部分地市已经不考察字音字形),中考语文试卷可以拆分为三大板块:

古诗鉴赏

文言文

现代文应用

我们期末期中考试等语文试卷,基本也是由这三大板块构成。

看到这里,肯定有人会疑惑:作文呢?分值最高的作文怎么不见了?

不忙。看这里:现代文应用,分为现代文的阅读与现代文的写作(部分地市的语言应用题也属于现代文应用范畴),现代文写作,不就是我们的作文题嘛。

为何我非要冒天下之大不韪而如此划分呢?

并非我为了哗众取宠。而是,现代文阅读与写作本来就是不分家的,特别是写作,离不开阅读,任何扬言能够不需要读书便速成的写作技巧都是站不住脚的。

在将试卷进行这三类划分后,同学们需要做的,就是找出你最近考试的两三次试卷,对照我的划分,看看哪一个部分失分特别多,这就是你的薄弱环间。然后针对薄弱环节进行加强即可。

如果你的失分在文言文比较重,那恭喜你,文言文是这三部分中最容易的。

你只需要认认真真,一板一眼地把从初一开始课本上所有文言文课本出现的实词虚词,文言句式等一个字挨一个字地整理一遍,该背的背,该整理的整理,你的文言文水平一定会有一个质变。然后辅之以几套文言文题目,刷刷找找感觉,分数就能很快上一个台阶。

如果你的失分在诗词鉴赏比较重,它的提升难度略大。

你首先要做的,是将从初一开始,课本上出现的,包括你语文老师补充的课外需要识记的诗词,该背的背过,该默写的默写,首先做到默写填空不丢分。然后,网络上有许多的诗词资料,包括主要的古典诗词意象,主要诗人的风格,不同题材的诗词的情感色彩答题术语等等,找一份出来,认认真真地学一下。然后,找几份近年来的中考诗词真题,做一做,特别是对照着答案看看差距在哪里,答案的得分点是怎么分布的,几套题做下来,你的古典诗词鉴赏题就能基本及格了。如果你要求更高,可以读一读古典诗词方面的鉴赏专著,比如我推荐给我学生过的《月迷津渡》,但是不建议古典诗词水平不到位的同学读,一定要在基础打牢固,并且自己对古典诗词也感兴趣的前提下去读。要不然,读此类书就是受罪。

如果你的失分在现代文应用上比较多,(绝大多数同学都是在此失分最大,谁让它占比最重呢?),那我的建议是,掌握现代文答题的技巧固然是必须的,但是脱离了阅读与积累的情况下,仅靠答题技巧和作文套路,哪怕能在一两次考试中取得不错的分数,但必然也是昙花一现。

对于初一初二的同学,大量阅读自然不需多言。即便是初三同学,我仍然建议,要读书,只是较之于初一初二同学可以大量泛读不同,要着重在精读细读上下功夫。

其实,我们中考语文整体的难度并不是很大,在整体难度不大的情况下,它对于语感的要求却不低。特别是许多语言应用题,许多同学一定有这样的体验:我能够凭感觉做对,但我却说不上来为什么。

这种说不上来的感觉,就是语感。语感的获得,唯有通过阅读。

不管是初一初二还是初三的同学,阅读一定要注意有效性。

这也是为何许多同学困惑:我读了不少书,语文成绩还是不行,是不是读书没有用?

不是读书没有用,而是你的阅读有效性不够高。这种有效性,一方面依赖于阅读材料的质量,另一方面,也是发挥着决定性作用的,就是同学们的阅读,到底是浮于表面,还是真正地在进行阅读、理解与思考。

一个真正有效果的,能够作用于提升语文成绩与作文水平的阅读,是不仅要动眼睛,更要动脑子,动笔头的。

换句大白话,也就是,要写读书笔记。

这不是什么秘诀,几乎每个语文老师都会要求同学们来写读书笔记。但是,据我了解,绝大多数的读书笔记都是“应付作业”。随便翻开一本书,挑一两段看起来还不错的段落,也不管它上下文到底在说什么,随随便便摘抄到本子上,就算是完成了任务。这属于“消极怠工”式读书笔记,没什么用处。

还有一种读书笔记的误区,也不少见。有很多同学,会准备一些精美的小本子,然后从一些来路不明的“精美散文”或“网络美文”中摘抄一些或华丽或忧伤的小句子。我很欣赏这些同学的态度,非常认真,如果仅仅将这种笔记作为一种爱好,当然无可厚非。可是,如果我们对做读书笔记抱有帮助提升作文和语文成绩的期望,那此种笔记也达不到效果。

综上两个例子,我要讲的意思就是:第一,我们做读书笔记的材料本身必须精挑细选;第二,读书笔记必须遵循一定的规范。

第一点我先暂时不展开,因为每个同学的兴趣点和基础不一样,也不可能有一个统一的书单提供给所有人。我唯一强调的是,我们要有意识地对阅读材料进行分类。即区分哪些需要泛读,哪些需要精读,哪些需要一读再读。泛读的材料,可以不做笔记;精读的可以写读后感;值得一读再读的,便可以选择写读书笔记。

我们今天重点来讲值得一读再读的材料的读书笔记应该怎么做。

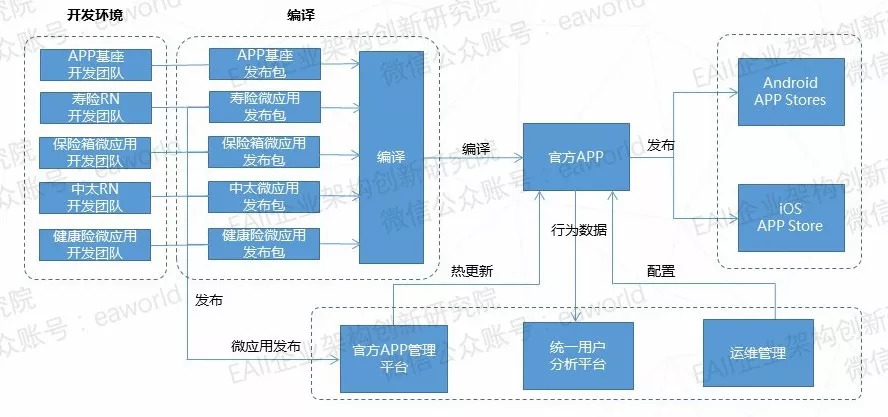

我以我一个初一学生最近做的萧红《回忆鲁迅先生》的读书笔记为例子来讲。

稍微交代一下此读书笔记的背景:前不久我们共读《朝花夕拾》,我给这位同学提供了萧红的散文《回忆鲁迅先生》作为补充材料,目的是让同学们对于鲁迅有一个比较形象亲切的感知。我并没有要求对此材料做读书笔记。但这位同学在课后,主动做了《回忆鲁迅先生》的读书笔记。即如下:

![]()

为了方便同学们阅读,我在此贴出来的是未批改版,所以内容上会有些许的误差和有待商榷之处。(图已打码,请勿盗图,盗图必究)

这篇读书笔记主要分为了四个部分。第一部分是词汇积累;第二部分是语段分析;第三部分是作者生平;第四部分是阅读感悟。

一个读书笔记,分为这四个板块,是很合理的。基本上需要同学们积累和总结的都涵盖在内了。

我重点强调第二部分,也就是“语段分析”,这是一份读书笔记中的核心部分,也是最容易整理地不好的地方。

一般来说,我们整理语段,可以从两方面入手。第一方面是语言方面,即写得特别优美动人的段落。第二方面即如本示例所整理的,能够在塑造人物或突显主旨方面有重要作用的,应该整理下来,并且进行分析。此文蓝色笔迹便是进行的语段分析。

这个分析过程,其实就是一个进行文本细读的过程,一个做阅读理解题的过程,更是一个学习具体的写作技巧的过程。而这个过程,恰恰是大多数同学的读书笔记中所缺乏的。

在这个分析过程中,同学们能够真正地对文本进行认知与思考,而我作为老师,通过对此分析的批阅,亦能够及时了解同学们理解不到位之处,需要进一步分析与讲解之处。

比如,此文第一个语段的分析便不到位。当这种不到位通过读书笔记的形式暴露出来,我们便可以着重地进行详解。通过讲解前后的理解的对比,通过认识自己分析不到位的缘由,发现自己阅读理解的思考误区,从而能够更具操作性地掌握阅读理解的技巧和方法。

以上便是在试卷拆解基础上,我们针对性地提升语文成绩的不同路径。

我再多说一句:语文学习有方法有技巧,但真的没有捷径。

部分比较聪明又善于总结答题技巧的初中同学,能够在不怎么读书的情况下,语文也考得不错,便宣扬“语文成绩可以与读书脱节”“只靠刷题一样能得高分”。

小朋友们,此话真的不能当真,听听就好了。因为初中语文比较简单,当你进入高中后,语文难度一下子会拔高很多,而没有阅读底子的同学,很快便会在阅读速度,理解能力和写作能力上暴露出很难弥补的短板。为何说很难弥补?其实通过大量阅读,半年左右就可以补上。但是,高中生,真的没有这个时间。

语文学习,不要想着偷懒,今天偷的懒,迟早要还的。

————————————

公众号:一吨语文,更多语文学习干货!

——————————————

……二更…………

二更来聊一下初中作文,这也是我教学的主业。但是,任谁也不可能写个几千字就能把作文给讲透了,同样也不存在看几篇文章就能把作文写好。如果作文这么简单,它就不可能值50分(有的地市60分)。所有的作文方法论,都需要一更中提到的大量的泛读与高质量的精读为底子。

这次更新,我以20年上海中考两篇作文为例,来谈,我们初中同学如何找到和明确自己的写作方向。

上海市20年中考作文题目为《有一种甜》。我们直接来看两篇考场作文:

先来看例文1:

![]()

再来看例文2:

![]()

显然,例文1是最不出乎我们意料的一种写法。

例文2,另辟蹊径,不落俗套。

如果我问例文2好在哪里,相信所有人都能头头是道:立意新颖深刻,语言精致优美,诗词积累也不错,等等等等。

例文2的好不需要分析,大家都一目了然。

我要问的是,例文2,最大的不好在哪里?

对于我们绝大多数同学而言,例文2最大的不好在于“不好模仿”。我们能够很好地欣赏它,却绞尽脑汁也很难模仿借鉴它。

其实例文2的立意和结构很容易借鉴,其中涉及到的诗词其实也大多课内,但是,支撑整篇文章的语言,不容易学。这既涉及到细腻的文学感悟力,也涉及到遣词造句这样基础的文字把控能力。也就是,我们能够非常容易地掌握它的框架,但却填充不了内容进去。

当然,对于少部分同学,则不存在这个问题。比如,我们完全可以运用例文2的写法,以《钢铁是怎样炼成的》为对象,运用于“难忘的一段经历”“特殊的一段友谊”此类的题目下。至于这部分同学是如何获得“让骨架长出血肉”的能力的,就要回归到一更中提到的阅读与积累。

话说回来,我们现在暂时回到关于例文2对于大多数同学而言“不好模仿”的讨论上。

我现在说例文2“不好模仿”好像没什么新奇,但在同学们实际的作文中,却有相当大一部分同学喜欢写例文2此类的文章。我们暂时将此类作文称为“好高骛远”的作文。

这种“好高骛远”的作文,表现在卷面上就是:看不起写简单小事,不愿意踏踏实实把小事写好,醉心于在作文中填充大而无当的素材与华而不实的语句。

此类作文往往会出现“形散神散”“主旨不清”“不知所云”此类毛病。

比如,半命题作文:XX,我为你拍照。有的同学选择写的是《祖国,我为你拍照》,立意没有问题,但由于主题太过宏大而很难操控,最后沦为了几个素材的拼凑。

对于作文有这种问题的同学,我总是说:不要走不稳当就想跑,踏踏实实写好身边一件小事就会是一篇很好的记叙文。

虽然当面所有人都点头,但我知道,许多同学都对此不以为然:例文1这种作文太小儿科了,简直就像小学生作文!既不华美,也不深刻,也没有什么好词好句能被圈点出来。在高大上的例文2面前,它太素面朝天了。

对的,例文1确实朴素,不像例文2让人一眼看过去就感慨:这位同学很厉害。

但是,我们参加中考,追求的是别人夸你厉害吗?

不是的,我们追求的是考个高分。

既然一篇语言朴素的记叙文和一篇语言厉害的小散文(语言只是它们能够获得高分的一个方面,其他的要素我们暂且不论),都能够获得不错的分数,那干嘛不量力而行,选择适合自己模仿和借鉴的道路呢?

一定有同学会反驳我:你说的道理我都懂,我也知道自己啥水平,但例文1一眼看过去不够惊艳,我写这种作文就怕被老师误以为我就是小学生水平。

想要搞清楚这个问题,那我们就要明确,初中生记叙文,到底是要我们写什么。

初中记叙文到底要让我们写什么呢?

其实就是写你的经历和感受,也就是你的所见所闻在你心中产生了怎样的“所感”(不能违背基本法律和道德规范)。

能够把所见所闻所感写明白,写生动,就会是一篇特别漂亮的文章。

你无需用“是否对他人有价值”“是否站在很高的角度”这些标准去要求初中记叙文,这些误区所催生出的“扶老奶奶过马路系列”“马路边捡到钱系列”已经够吐槽二十年了。

记叙文,本来就是记录一个独特的个体的独特的经历和体验。对你这个个体有触动,就够了,哪怕再微不足道,但我们的成长不就是这样一点一滴,一步一步地过来的吗?比如我们课本中的《散步》,《荷叶母亲》,《背影》,都是生活中小得不起眼的小事,但却因为它们对作者产生了触动,所以为作者所铭记,并用高妙的笔将这份经历和触动记录了下来。

再比如我们今天提到的例文1,主要写的就是被选为剧社社长让自己特别高兴这样的一个经验。没什么特别深刻的意义。但是,这是一个真实独特的成长经历。字里行间,我们读者能充分地体会和分享到了作者对于戏剧的喜爱以及对于这份肯定的珍视。我们甚至能感受到,作者是如何脸带笑意地来回忆这份“甜”的。我们往大了说,这个“甜”的选材,也是具有现实意义的,它就是我们当代青少年阳光幸福生活的一种反映,是具有代表性的。当然,没必要非要上纲上线地往“大”了来提升它。它的核心价值,还是在于对作者个体的意义。

在明确了选材方向后,接下来我们要做的就是要分析它,学习例文1是如何把这份“甜”写好的。我们要从结构上拆解,也要从语言的具体表达上分析。因为我们今天重点针对语言基本比较薄弱的同学来谈,所以,我们重点分析这篇看似朴素的记叙文,在语言表达上,我们可以学习什么。

我们以矛盾冲突最激烈的这一段为例来说:

“什么社长啊?”爸爸揉着眼睛,“看把你激动的!”“课本剧!课本剧!”“语文老师推荐我做分剧社的社长了!”我边叫边蹦,把昨晚工作到深夜的妈妈吵醒了。妈妈满脸怒气地说:“语文老师的课你都敢不上,还想当社长?快去上课!”“我,我当社长了啊!”“当社长就可以不好好上课吗?上课去!”

这一段没有任何的“好词好句”,但把冲突场面再现地不错,特别是人物的对话,话顶话很紧凑,而且符合人物身份,尤其是“妈妈”的台词,几乎每一个中国老母亲们都会如此咆哮,这个安排特别真实,我们几乎要会心一笑:是啊,妈妈总是这样的,只关心上课和考试。

再看“我”的台词:“课本剧!课本剧!”连着两个课本剧,而且都是感叹号,简短有力,把“我”激动,亢奋,迫不及待的状态就写出来了。被“妈妈”吼了第一句之后,“我”又怎么说的:“我,我当社长了啊!”虽然此处没有写“我”被当头泼了冷水后的小蒙圈,但通过话语里一点点的小磕巴,把“我”争辩的态度便写了出来。

此外,我们还要重点注意到作者的动作描写,神态描写,但这两点略微逊色。

经过如此分析,我们就学到了这位小作者的一点点小妙招。总结如下:第一,人物语言要合乎人物身份,在尽量真实的基础上,根据主旨表现的需要进行适度的文学修饰。千万不要动不动就写:妈妈语重心长地说“要为祖国四化而努力学习啊!”。这种道理虽然不差,但语言明显不够生活化,作文写出来就假。第二,表现人物的情绪,可以通过具体的语言和语气,比较委婉地传达给读者,不上一定要直白地“我兴奋地喊”“我委屈地说”来表现情绪变化。

这两点很难吗?其实并不难。而且它对于语言的精美度要求不高,准确即可。

同样写一件小事,优秀作文与普通作文的差距,就在于一点点的这些细节的不同。绝大多数人都能够写“父亲吃力地穿过火车道”,只有极少数能写出父亲具体的动作:“探身”“攀”“缩”“微倾”。我们也许无法一起步就能写得特别好,这也是不现实的,但经常对照考场优秀作文和课内外优秀作品来分析学习,每一篇都比上一篇有进步,相信我们可以写出优秀的记叙文。

为避免引起歧义,我重申一下,我强调写好一件身边小事就能是一篇优秀的记叙文,并不意味着我对例文2此类小散文,以及考场议论文等这些写法的否定。对于学有余力的同学,我们当然愿意看到他们的创新。此前我对于《有一种甜》这个题目的写法,就已然提供了许多不同的角度:

比如,善于观察生活,情感比较细腻的同学,可以写“奶奶包的粽子的那种甜”这种生活小事,写一篇细腻的情感文出来;

比如,关注社会生活,喜欢针砭时弊的同学,可以从“奶茶的许多甜味都是勾兑的”,来写一篇小小的时评文;

比如,对时政热心,比较擅长写主旋律的同学,可以从“抗击疫情中的温暖细节”等角度,来写一篇反应社会中人与人之间温情的小议论文;

比如,对于喜欢哲思与辨证的同学,可以从“甜蜜的糖衣炮弹”这样的角度,来进行对“甜蜜舒适”的思辨;

比如,对于喜欢文学的同学,可以将文学带给你的阅读体验这种“甜”来入手,写一篇入门级别的文学评论;

我今日所做的分析,都旨在说明,踏踏实实,从写好一件小事开始,这是我们整个初中作文的起点,而且如果能够真的写好一件小事,完全也可以作为初中作文的终点(中考作文)。

——————————————

第三更: 本次更新是针对性解决初中生记叙文“无事可写”的问题。这部分内容出自我的另一个回答。可惜那个问题流量太小了,我不忍心这个超级好用的方法称为“沧海遗珠”,便把它搬了过来。

许多同学都存在记叙文“无事可写”的问题。我们老师经常说:“要观察生活,善于从生活中寻找写作素材”。

道理是这么个道理,但生活应该怎么观察呢?谁来给我解开这个千古谜团。

如果你也存在这个困惑,那就跟我一起去我们的语文课本中寻找答案。

举个例子来说吧。现在我们要写一篇歌颂“母爱”的作文。

抓耳挠腮,不知道该写什么。

那我们来回忆一下,我们的课本中,比较经典的,关于“母爱”的课文。

我首先想到了《秋天的怀念》。

《秋天的怀念》写的是史铁生的母亲劝慰史铁生出门散心,最后自己却撒手人寰。

我们当然没有史铁生残疾和痛失母亲的经历,那这篇课文对我们写“母爱”的作文有什么借鉴意义呢?

如果你觉得没有意义,是因为,我还没有给你抽离出这篇课文的骨架。

我把《秋天的怀念》写母爱的骨架抽离出来,其实就是:

我遭受了挫折——自暴自弃——母亲鼓励我——我开始扭转心态

看到没有,这就是《秋天的怀念》的骨架,也是它的行文思路。

你只需要去思考一下,你的生活中,遭遇了怎样的挫折,你的心态发生了怎样的变化,你的母亲又是怎样来劝慰你的,对你产生了怎样的影响。把这些发生在你身上的事情组织一下,按照《秋天的怀念》的框架来安排,就会是一篇不错的作文。

你可能会说,我身上没有经历史铁生那样的遭遇,怎么可能写得深刻?

同学呀,你要追求的根本就不是对标史铁生的深刻,这种深刻本来就不是普通的十几岁的健健康康的中学生能体悟和抒写的。

你要追求的,是学会史铁生是通过什么(即文章的骨架)来写母爱的。

你往这个骨架里填充的应该是你生活中那些平凡而微不足道的小挫折小感动。比如考试考得不好,朋友闹了矛盾,自己被长辈误解等等。

史铁生提供给你了角度,思路,框架,结构,一篇作文,绝大多数的问题,他都给你解决了。你只需要稍稍动动脑筋,想一个自己生活中的事情,然后用丰富的细节来填充史铁生给你的作文骨架,就可以了。

作文,就变得如此的简单,so easy.

退一万步,你的生活一帆风顺。你实在是没有经历过挫折,或者你的母亲没有在你遇到挫折时给予足够的关怀。

那怎么办?

我的建议是,放弃《秋天的怀念》这个思路,转投其他,而不是按照《秋天的怀念》去进行编造。

为什么不鼓励编造呢?虽然我们有了骨架之后,编造变得易如反掌。

因为,没有真实的经验,你的编造就只能泛泛而谈,无法有细节描写。而没有细节描写的记叙文,就是空中楼阁。

连脚都站不住的作文,怎么可能打动人呢?

在决定转投其他时,我们还是从课本下手,找一下其他的值得模仿和借鉴的佳作。

我又想到了《散步》。

《散步》我以前专门写过,为了省时间(偷懒),我还用这个例子吧。

《散步》讲一家人去散步,奶奶想走大路,因为大路平坦,孙子想走小路,因为小路有趣。作者选择了大路,但奶奶为了孙子,让作者选择走小路。

《散步》的骨架抽离出来是这样的:

发生矛盾——内心活动——化解矛盾

看到没有,这就是《散步》的骨架。

这个骨架下,你总会有事可写了吧。

我们的生活本来就是每天都充满了选择和矛盾,特别是我们中学生,与父母的矛盾简直不要太多。

母亲逼迫我刷题,母亲逼迫我穿秋裤,母亲不同意我与同桌谈恋爱,母亲不同意我骑自行车上学,母亲不同意我只吃肉不吃菜。对吧,这种事情在我们生活中几乎人人都会遇到。

这就是你与“母亲”之间的矛盾。

这些矛盾发生时,你经历了怎样的心理过程,最终,这个矛盾是如何化解的,或者是因何无法化解的,把这个写出来,就会是非常出色的一篇作文。

比如,你母亲逼迫你穿秋裤。你说你不冷,你不穿。你反抗她对你生活无微不至的关怀。你认为这种关怀几乎等同于专制,自己毫无自由。于是你感觉自己就像一个孤独的战士,为了反抗这种压迫,你就是没穿秋裤,毅然地摔门而出,在寒风中向学校走去。

如果你在学校感觉冷了,你会不会突然醒悟自己“孤独感”的可笑,并察觉到母亲逼迫你穿秋裤的内涵是对你的爱。然后,以第二天穿上秋裤这种无言的行动作为自己的歉意。(看到么有,矛盾就这样化解了。重点写你态度转变的心理过程,以及你穿上秋裤时的心理活动。)

如果你在学校一点也不冷,但经过一天的冷静,你察觉到母亲逼迫你穿秋裤的内涵是对你的爱,你回家就可以告诉你妈妈:我真的不冷,因为我长大了,我已经能够知冷知热,照料好自己的生活。(看到么有,矛盾也化解了。重点写你是如何克服羞赧与自尊向母亲“示弱”的,以及你母亲听到你这些话的反应。)

如果你在学校一点也不冷,回家后,你仍然很生气,便冲你妈妈发火:我一点也不冷,你还非要我穿秋裤!什么都要管着我!然后你们爆发了一场激烈的冲突。最后不欢而散,你感觉自己受尽委屈,非常孤独。(矛盾虽然没有化解,甚至还加深了,但你仍然可以写啊,写为啥没化解,原因在哪里,这种专制的爱,对你而言到底意味着什么。把这个写出来啊,也会很好。但是,我唯一要提醒的,就是不要站在道德的制高点上随意指责任何人。反思,你要做的是,反思。反思矛盾为何没有化解,你的问题在哪里,对方的问题在哪里。这样的作文,才是正能量的,有价值的。)

写了这么多,我想聪明的你,一定get到了我的意思。

生活本来可写的内容就特别多。(你看,关于穿不穿秋裤,都可以写这么多话出来。这还只是个提纲而已。)

既然凭一己之力无法取材和组织文本。那就充分地借助课本吧!

关于“母爱”这个主题,我们课本中还有几篇特别好的课文。同学们可以试着像我一样,来整理这些课文的骨架,学习这些作者选材的角度,为自己所用。

然后,这些骨架要推而广之。

你会恍然大悟:原来,作文可写的能写的实在是太多了!

————————————

公众号:一吨语文,更多语文学习干货!

——————————

——第四更——-

本次更新,我想再分享一下关于课外阅读的看法。

很多很多年以前,我读初一时,有两本书给我留下了至今无法磨灭的印象。一本是《子夜》,一本是《牛虻》。前者是因为篇幅过巨,后者则是因为我读不太懂。彼时的我,将读不懂的原因全部归结在自己身上,并且充分发扬了刨地精神,用最笨的方法开始读《牛虻》——抄书。

“抄书”就是字面意思,一个字一个字地比着抄。抄的过程就不细表了,总之全部抄完,并且,真的通过抄看懂了这本书。

这是一个非常笨的方法,年代特色明显,效率极其低下,完全不值得推崇。

但是,通过这一件事情,我却发现,彼时的初一的我,已经开始了理解的自觉。(自吹自擂)

换句话说,我在主动地想办法去理解我读的书,而不是限于翻一遍知道情节就满意了。

对一本书产生属于自己的理解,是我们阅读中应该存在,而且极其有价值的一个环节。

我为什么强调是“属于自己的理解”。因为这里有一个读懂的“标准”问题。有一种说法:作品属于读者,文学鉴赏本来就没有标准,自己想怎么理解就怎么理解。这样说可以,没问题,一千个人有一千个哈姆雷特嘛。但这个说法有个隐含的前提,那就是,我们不是在“学习”的情境中。

如果我们将自己的身份设定为学生,并将阅读放置于“学习”的情景,就会发现,“文学理解”无法彻底放飞。必须有一定的准则。

这个准则具体到考试的阅读理解中,就是“参考答案”。

这个标准具体到课内文本的教学中,就是“段落大意”与“中心思想”。

这个标准具体到课外文本的阅读中,它变得稍微自由了一些,同一个问题下可以诞生多个不同的答案,只要言之有理自圆其说即可。这就是属于你自己的理解。这个理解,未必非要与作者一个鼻孔出气,但却仍然必须建立在能够掌握情节、不脱离基本设定、与人物共命运的基础上。

在这些基础上产生的属于自己的理解,对于我们的理解能力或者鉴赏水平的提升,才是比较有价值的。唯有这样才能称得上读懂。

而读懂与读完,是两个完全不同的概念。

这两者的区别到底在哪里?对阅读效果会有多大的影响?我们举个例子来说。

最近,我的两个学生都在读《人生》。课上我与他们交流时(我的课堂是1对1课堂,分别交流,两位同学是互不知晓互不干扰的),我问了他们一个共同的问题:高加林最后为何会一无所有?你认为最重要的原因是什么?

甲同学跟我说:“因为高加林太过于积极进取了,他急于想要成功,但积极过了头就是激进,所以栽了跟头。”

乙同学跟我说:“因为高加林身上有落后文化的影响。这种落后文化就是文中农村人身上体现出的不识字、不讲卫生等恶习。”

之所以问这个问题,绝非是要苛求同学们谈出多么深刻的认知,我们要尊重青少年的认知发展规律。我所期待的,就是如前文所言,形成自己对这个人物的理解。

但这个理解,一定是要在学习的情境中,在符合人物基本设定,与人物共命运的基础上,提出的一点点看法。

按照这个要求来看。如果你还对《人生》的情节有一定的印象。我想你大概率会认同我的判断:甲同学对《人生》已经有了一定的理解;乙同学则在理解上出现了比较大的偏差。

这个例子,我想已经很形象地说明了“读懂”与“读完”两者的分野。

如果我们的阅读止步于读完,我想,大概率要仰天长叹了:读书没有用啊!

那问题来了。我们该如何判断自己是读懂还是读完了呢?怎样读才能尽可能地读懂呢?

那就是一定要多问自己几个为什么。

不同的文本,甚至具体到每一个篇目,我们的“为什么”都不一样。就《人生》此类书写普通人命运的小说,必然要问的一个“为什么”就是:主人公的命运为何会如此发展?(相似的变种问题:主人公为何落得如此下场?主人公为何做出这种选择?什么因素左右了主人公的命运?主人公的命运是由哪个重要情节决定了的?)

多问几个“为什么”,并不仅仅是对作品情节的回顾,更重要的是,这是一种特别好的思维训练。它训练我们在阅读中带上自己的脑子,学会分析,从而形成自己的看法。

这种“为什么”的追问,不一定非要形成书面的材料。完全可以在与同学、老师、家长的交流中完成。

前一段时间,一位学生的家长,也是我的一位知乎的读者跟我交流:“我家孩子在读《骆驼祥子》时,说了这么一句话:祥子也不是个好人。”

这一句话,让我一下子来了精神。我连忙追问:“他为什么这么说?我真的很想知道他的理由。”

可惜,这位家长告诉我,她当时姑且一听,并没有与孩子就此深入地交流。

我觉得特别遗憾。这么看似随口一说的话,其实,就是这位同学对《骆驼祥子》理解的火花。

顺着这个火花,我们可以鼓励这位同学去思考:什么是好人呢?好人必须是完人吗?存在完人吗?如果不存在,那怎样才能称为好人?

经过这一系列的思考,这位同学也许能够推翻自己的最初的判断,或者更加坚定自己的判断。这些都不重要,重要的 是,在这个过程中,他对于文本有了更深入的了解,对祥子有了更全面的把握,自己的思维能力得到了极大的锻炼。

有的人可能会对此嗤之以鼻。这些问题有意义吗?考试又不考。只要在考到祥子的人物形象时,能够写出“祥子善良纯朴,热爱劳动,对生活具有骆驼一般的坚韧的精神,但他身上也有缺点,比如爱说谎话,好占便宜。”就行了。又不会考他到底是不是好人。

可是,如果我们把课外阅读的目的,仅仅局限在那价值5分的名著题上,我只能遗憾地说,如此短视的学习很难令语文有长足的发展。

我们对名著进行理解与思考本质其实是一种认知训练。这种认知训练,在初中阶段只是一个萌芽状态,在高中阶段,深层次的认知才成为语文考察的重点。但初中阶段不是考察重点,却并不意味着它不存在,不生长。我们应该有一个宏观的语文学习观,全局统揽整个义务教育阶段的学习。而绝不能头痛医头脚痛医脚。

以上内容便是我讲的,在我们的阅读中,多问几个为什么,形成属于自己的理解的重要性的问题。

接下来,我想再分享一下,这种理解与读书笔记之间有什么关系。

很多情况下,我们并没有机会,或者说纯粹不想与他人分享我们对某本书的看法。此时,则可以选择通过读书笔记的方式,用文字来梳理自己的看法,哪怕是纯粹想吐槽一下主人公也好,完全可以在自己的本子上信马由缰一番。

我虽然用了“信马由缰”这个词,但绝不是真正想怎么写就怎么写,我们要尽量有条理地去表达自己。在有条理地表达中,你的本来模模糊糊的思考就会逐渐明晰,甚至深化,甚至扭转,都有可能。

借用王蒙的话说就是:“如果你不用语言来梳理你的思想,不用语言来生发你的思想,不用语言去梳理你的思想,那么你的思想是不可能成熟起来的。”

稍微总结一下,本次更新的内容是,我们要区别“读懂”与“读完”,读懂作品,形成自己的理解才是比较有价值的。而这个途径可以通过追问来完成。这种追问可以在对话讨论的情境中实现,也可以通过文字的表达来完成。选择适合自己的即可。

在此稍微回应一下评论区关于“读书笔记会不会破坏阅读趣味”的疑虑。答案是肯定的。毕竟没有哪个同学愿意写作业。

我鼓励同学们获得阅读的乐趣,但阅读乐趣与写读书笔记并不是非此即彼、水火不容的状态。一方面,我在一更中已经强调,我们要对阅读材料进行有意识的分类,并不是每一本书都有写读书笔记的价值和必要。另一方面,对于需要我们理解的作品的阅读,本来就不能闲庭散步,当自己不给自己定下一定的目标和要求,学习效果肯定会大打折扣。

希望同学们可以根据自己的情况进行阅读材料的分类,并且,尝试着用讨论或读书笔记的方法去梳理、表达自己的理解。相信一定会有所收获的。

——————————

我的公众号:一吨语文,更多作文学习干货

————————————

----第五更------

非常感谢大家对这个回答的认可。许多小学阶段的家长也“未雨绸缪”参与到了这个话题的讨论中。

本次更新来自于我对另一个问题“如何让孩子爱上语文”的回答。主要讲的是如何通过“口语表达训练”帮助同学们学会理顺思路和清晰表达。对于小学阶段,以及初中低年级存在表达困难的同学都适用。现在正值寒假,家长与孩子有了更多的相处与交流的时间。不妨试一试我所提供的方法,说不定有可喜的收获。

如下是经常在我课堂上出现的对话场景(对话对象为中学生,已做模糊化处理):

我:“这位主人公为何会做出如下的举动?原因是什么?”

同学:“责任,信念。”

我:“很不错,方向是对的。请你更完整和详细地陈述一下自己的看法。”

同学:“责任意识和信念。”

我:“可不可以阐述地再具体一点呢?”

同学在酝酿几秒钟后,会说出一两句完整的话,但意思却偏离了“责任”与“信念”。

这不是发生在一个同学身上的个案。它具有一定的代表性。

我常会思考,为什么,这些同学明明能够理解文章,能够用比较准确的关键词(比如“责任”“信念”)概括出自己对于文章的理解,但在要求详细地阐释时,却无法用完整的语段来表达自己呢?

当我鼓励他们去向着明明正确的方向(即他们自己总结的关键词方向)去进行完整表达时,他们却无法用准确的话语来表达自己,好不容易表达出来的语句却并不符合自己的初衷,甚至完全走向了其他的方向。

存在这个问题的同学,在书面表达与口头表达上,还有分化。有的会在书面表达时,能够比较清晰地表达自己。有的在书面表达时,仍然容易陷入混乱。后者,看他们的作文,总有一种特别遗憾的感觉:围着关键字眼一直在打转,极尽挣扎,就是说不到点子上。

理解没有问题,表达成为了他们的掣肘。

当我们一直以书面表达(主要为作文)作为评判一个人语文水平的唯一标准时,却疏忽了,书面表达的问题可能仅仅是冰山一角而已。而要解决书面表达的问题,追根溯源,我们发现,它可能不仅是简单的一句“孩子不会写作文”,而是“孩子不会表达自己”。

如上的分析与这个问题的关系在于:我们许多人,包括部分老师和家长在内,将语文的理解太狭隘,将语文等同于“字词句段篇章”。“口语交际”环节,很难进入到大家的视野。而对于低年级的同学们而言,“口语交际”其实就是行之有效的表达训练。

同样是语言学习,当我们拿起英语课本,背诵单词短语时,我们能够很明确地判断“我此时此刻在学英语”。但语文学习呢?几乎与我们的生活交织在一起,根本无法分开。

举个例子。

我曾经看到过这样一篇学生作文。这位同学做公交车,路过某个地方,等红灯时发现一个招牌写着四个字“阳光不锈”。这位同学面对如此意味深长的四个字感慨良多。当绿灯亮起,车往前开出去后,这位同学猛然发现,这个招牌完整的字眼是“阳光不锈钢”,顿时觉得俗不可耐。

这是不是语文的学习呢?

“阳光不锈”带给了她文学的审美,“阳光不锈钢”的大反转又像一个文字游戏让她体会到了语言的狡黠与多变。

这就是语文的学习。

可能有人会觉得,这样的机会是可遇不可求的。但在日常中,我们与同学们的每一次对话,只要留心,亦可以是非常好的语文学习机会。

比如,我们可能会出现如下的对话场景:

家长:今天运动会好玩吗?

学生:好玩。

家长:都有什么好玩的?

学生:额,都挺好玩。

“都挺好玩”,典型的概括。能不能举例子呢?我们引导着同学们去详细地描述一下让自己觉得好玩的事件。

家长:“你给我详细说说呗。”

学生思考一会儿后:“没啥好说的。就是挺好玩。”

家长:“具体的每个人都干啥了呢?你把你几个好朋友都干啥了跟我说说。”

学生:“小王调高没跳过去,摔了个大马趴。小李跟我一起跑接力赛了。小张跑长跑差点累死。对了,小王摔倒的时候,我还去扶他,他还不让我扶。”

此处的思路略微有点跳跃太大。这时就需要我们帮同学们顺一顺。

家长:“小王这件事很有意思。但你还没说完小王就去说小李小张,让我有点乱。咱们好好地先把小王这件事聊一聊。你再给我讲讲,他为啥摔倒,干嘛不让你扶?”

我们为何要鼓励同学们详细尝试小王摔倒这件事呢?目的有二。一是训练有条理地表达自己。二是帮助同学们观察生活,观察生活其实就是在积累写作文的素材。

划重点了。这就是在积累写作文的素材。

说到这里,我岔开说一句题外话。我接触的不少同学,在小学阶段都进行过这样的一个工作:背素材。有的是背作文书上的,有的是背诵媒体上的,不一而足。

当我们苦于千篇一律的“运动员表现了奋勇拼搏的精神”“我们班级展现了团结的风貌”这样的空话套话满天飞的作文后,在整天要求同学们写真情实感时,是不是要想一想,在要求孩子们“背素材”的时候,是不是已经将他们指向了一条并不明智的作文学习之路?

我们不能停留在口头上要求同学们“真情实感”“我手写我心”。在他们还比较年幼,没有足够的观察能力去观察生活,观察自己的情绪情感时,我们作为老师或者家长,就应该肩负起帮助同学们去观察生活,去发掘自己的情绪情感的责任。

这就是生活处处是语文。只看我们这些领路人,愿不愿意花心思,去进行这样的“教学”。

没有任何一个人是喜欢完成任务的。最好的教育肯定是春风化雨。在不知不觉中,让同学们进行了一轮“综合性”的语文学习。

语文是一门特殊的学科。它甚至超越了一门学科的属性,几乎成为我们作为人的一部分。我想,对于我们低年级同学的家长(也就是这篇文章的主要读者)来说,也许,我们可以先试着改变自己对于语文的观念,然后再潜移默化地进行语文能力的训练。(并不意味着对语文系统学习与阅读的否定,勿杠)也许,在我们的努力下,孩子自始至终都不会爱上这门学科,但至少不会妨碍他掌握必备的语文能力,并且考一个理想的分数。

————————————————————

——————第六更——————

这次更新我们来交流一下现代文阅读的问题。我们主要来探究一下两个常见的学习问题产生的原因,一是课内语文教学与我们的现代文阅读考试到底是何关系;二是为何许多同学背诵了答题套路却仍然效果不明显。

要做好现代文的阅读理解,特别是小说散文文体的阅读理解,一定是需要“两条腿走路”的。

一条腿是:能够读懂理解文本。

第二条腿是:能够掌握答题技巧和规范。

这两条腿,代表了两种不同的能力,都需要掌握,不可偏废。

读懂和理解文本的能力,主要的获得途径有二。

第一种途径是课文的学习。也就是上课好好听讲。

有同学可能会觉得学课文没有用,因为咱们考试时的阅读理解文章又不是课文。

但阅读理解文章只是一个载体而已,并不是考察内容本身。阅读理解题目真正考察的,是以题目为载体所反映出来的对文章的理解能力。(当然也包括一定的审题和解题能力,此处暂且不表,放在后半部分。)

这就是为啥,学霸不管考哪篇文章,都能考得不错。因为虽然文章变来变去,考察的能力却是不变的。

而这些理解能力,主要通过咱们语文课本的学习获得。比如,比较常见的一种题型:

19年绍兴中考阅读理解《父亲的露珠》

请围绕“露珠”,用简洁的语言将内容补充完整。(3分)

上苍分配露珠——(1)_____——(2)_____——(3)_____——追寻远去的露珠

19年威海中考阅读理解《薄荷》

阅读全文,请筛选出薄荷的特点。(3分)

这是信息的提取、归纳与概括题。考察的就是咱们同学们能不能读懂文章、理清楚文章的主要脉络、提取出有效的信息。

说起来有点玄乎。换句人话就是:这就是考察你是不是学会了老师上课讲的概括段落大意。

你会概括段落大意了,那文章你基本就能分层,就能理顺作者的思路,也就能把这种信息提取概括题做得七七八八了。

我们再来看另一个题型,赏析重点词汇题:

一般都是这么问:加点词语有何妙处?试着赏析加点词语。或者说,加点词能不能用另外的一个词来替换?为什么?

这考察的是咱们能否揣摩得出加点词在具体语境之下体现出来的微妙精巧的意义。

为啥要强调具体语境呢?

因为即便是最简单的词汇,在不同的语境之下,也会蕴含完全不同的意义。

比如这两句话:

你可真厉害,这么难的题目你竟然做对了!

你可真厉害,这么简单的题目你竟然做不对。

再看这两句:

这个人一年只洗一次澡,是这条街上最脏的人。

这个人偷鸡摸狗无恶不作,是这条街上最脏的人。

“厉害”“脏”都是很简单的词汇,但在不同语境之下,表意千差万别。

另外还有一些看起来比较相似的词汇,其实表意会相去甚远。比如:

李雷和韩梅梅在一起做值日,李雷时不时地瞄韩梅梅几眼。

李雷和韩梅梅在一起做值日,李雷时不时地看韩梅梅几眼。

李雷和韩梅梅在一起做值日,李雷时不时地盯韩梅梅几眼。

“瞄”“看”“盯”三个词表意看起来差不多。但放在具体的语境里,却相去甚远。李雷“瞄”韩梅梅,这个动作不是明目张胆的,而且是迅速地,装作若无其事的。这里的李雷,怕被韩梅梅发现自己在偷看,有点儿羞赧。

李雷“看”韩梅梅,就大方多了,正大光明的,不害羞,大方磊落。

“盯”,这样看女孩子的男孩,几乎有点儿呆了。

这三个字,看起来是近义词,其实到了具体语境下,表意相去万里。

这种对于词汇具体语境下表意的(包括隐含的作者的态度情感)的把握,其实就是咱们课内讲课文时老师的“咬文嚼字”。所以下次语文老师非要跟你讨论“捏着钢叉”为什么就是比“握着钢叉”好时,千万不要以为老师在“无聊”,在“做无用功”。

看似无用的讲课文,其实真正地有大用。

只是由于我们没有充分地察觉到或者说建立起“上课讲的内容”与“考试考的内容”之间的关联而已。

以上就是第一条腿走路的主要方法。当然,认真听课只是基础,能保证你会走。想要走好走快、甚至想能跑会跳,则需要课外的大量泛读和有效精读。

我们再来说审题技巧和答题技巧上可以做哪些工作。

对标参考答案找差距、总结答题术语和规范、甚至包括背诵一定的答题模板,都是常规性的技巧。人人皆知。

并非人人皆知的是,在做这些事情之前,其实我们还要去做一项工作。就是搞清楚在阅读理解题型中经常出现的一些学科概念。

比如,我们以这个题型为例:

请赏析一下划线句子:

蘑菇屯村民们对我夹道欢迎,锣鼓喧天、鞭炮齐鸣,我的耳朵都要聋了。

这类赏析句子题,一般就是从描写或者修辞的角度来答。如果是从修辞角度来回答,教辅资料总结的答题的话术一般为:这个句子用了……的修辞手法,心想生动地写出了……的特点,起到了……的效果,表达了作者……的感情。

背诵这个答题话术其实一点也不难。但即便你背过了这个“公式”却仍然无法拿满分。

因为,极有可能判断不出来这到底是一个什么修辞。

如何才能判断正确?

那这就涉及到,我们必须把常用的修辞手法(拟人 比喻 排比 设问 反复 夸张)到底是什么先搞清楚,不仅搞清楚,还得记清常见的修辞手法有哪一些。这样再做这种题时,如果不是那种简单到一眼就能判断出的修辞类型(排比、拟人、比喻相对来说非常容易识别),你完全可以如做选择题一般,拿着需要你赏析的句子,去你的脑子中挨着比对这几项主要的修辞手法。如同做选择题一般。这样判断出来的概率就非常高了。

判断出修辞手法,这个题目还有可能会被扣分。扣分的点就在于“分析”。也就是分析这个句子到底是如何使用该修辞手法的。这是这个题目真正的难点所在,也是拉分的地方所在。也是语文真的好的同学与语文一般的同学的区分度所在。

而想要写好这个修辞手法到底是如何使用的,而不是说来说去就是“形象生动”这四个字,这就主要依赖于第一条腿培养起来的感悟力,当然也必须辅之以对大量的参考答案的模仿与总结。

以上说的是答题技巧上要做的工作,在审题技巧上,一样的。

比如,我们来看如下的几个问题:

请分析划线句子在文章中的作用。

请赏析划线句子。

请简要回答划线句子的表达效果。

划线句子有什么作用?

请理解一下划线句子的含义。

这几个问题是不是都特别常见呢?

头大了吗?晕了吗?

如果你都分不清楚这些问题,被再多的答题话术有什么用?

还不是照样对不上号?

出题人稍微一变化提问方法,就觉得自己遇到了一个新题型,然后一发下试卷来,就拍着大腿悔恨:竟然是从这个角度答!我明明就会的!

这就是为何,在各种教辅资料都已经把答题话术总觉得比较到位的情况下,语文阅读理解仍然做不到“开卷考试”,甚至总有一部分同学感觉自己做了很多题、背了很多套路却仍然“睁眼瞎”的原因。

——————————

公众号:一吨语文

更多语文学习干货

本文将持续更新,有兴趣看到新增内容的知友请点亮追更吧。