DB2版本 v9.5.0.4

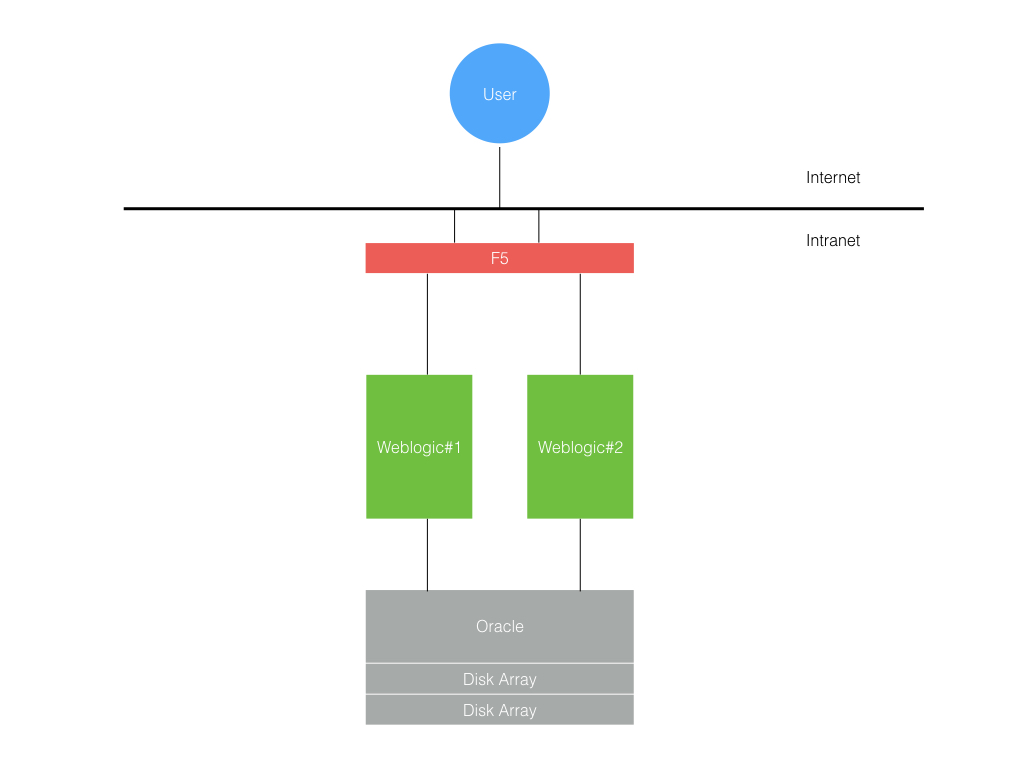

weblogic版本 10.3

aix版本 6.1.0.0

jdk版本 1.6.64

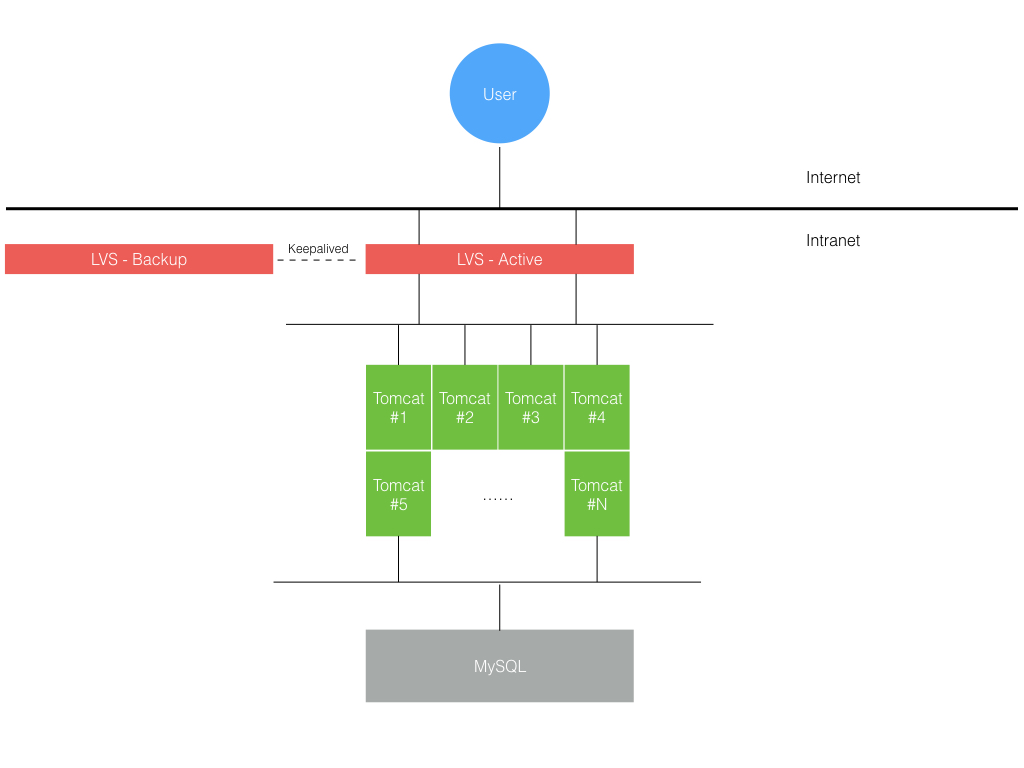

mysql:Server version: 5.5.32-enterprise-commercial-advanced MySQL Enterprise Server

Linux上jdk版本:sun:jdk1.6.0_37

linux上无法使用jps、jstat等工具:

执行这个命令即可使用:

export PATH=/usr/java/jdk1.6.0_37/bin:$PATH

weblogic启动脚本:

C:\bea\user_projects\domains\mapsDomain\bin\startWebLogic.cmd

C:\bea\user_projects\domains\mapsDomain\servers\AdminServer

flex编辑工具

C:\Program Files\Adobe\Flex Builder 3 Plug-in

D:\MyEclipse 6.0\eclipse

flex project

会自动编译生成*.swf

生成完swf文件以后,将*.html和*.swf拷贝到

maps_mng\WebContent\com\cup\maps\portal\jpf\flex

<2010-6-4 上午10时14分06秒 CST> <Warning> <JDBC> <BEA-001129> <Received exceptio

n while creating connection for pool "mapswebDS": [jcc][t4][2043][11550][3.50.15

2] 异常 java.net.ConnectException:打开端口 60,000 上服务器 /172.17.252.84 的套

接字时出错,消息为:Connection refused: connect。 ERRORCODE=-4499, SQLSTATE=0800

1>

com.cup.common.dao.util.PersistenceException: Unable to resolve 'jdbc.glmondb'. Resolved 'jdbc'; - nested throwable: (javax.naming.NameNotFoundException: Unable to resolve 'jdbc.glmondb'. Resolved 'jdbc'; remaining name 'glmondb')找不到数据源.

原因:没配数据源

URL:jdbc:db2://172.17.252.151:60001/glmondb:currentSchema=GL_MONDB;

Driver Class Name:com.ibm.db2.jcc.DB2Driver

user=gl_monap

portNumber=60001

databaseName=glmondb

serverName=172.17.252.151

Password:glmonap

JNDI Name: jdbc/glmondb

log位置:

D:\bea\user_projects\domains\base_domain\appLog\cups_maps.log

flex项目改好的swf和jsp文件需要copy到如下目录:

maps_mng\WebContent\com\cup\maps\portal\jpf\monitor\

然后必须要ant build项目maps_mng,然后重启weblogic才可以显示改动地方。

ant build 脚本位置:

maps_mng\script\build.xml

那cvs上传的文件应该是swf还是我改的mxml文件

都上传,swf是编译出来的目标文件,mxml是源文件

公共参数管理代码流程:

入口:

CommonParaSyncMainOperBean.operEtl(String paraCom,Integer syncBatNo,Map<String, String> jmsMap)

参数:paraCom 当前类型所包含的主题域

syncBatNo 批次号

jmsMap jms传递的map,包含参数类型和是否强制同步信息

syncService.syncPara(Integer.toString(syncBatNo), mainPt.getTblId(), userId, mainTableData);(CommonParaSyncServiceBean.syncPara)做了下面几件事:

1、通过同步批次号、表ID、用户ID、参数数据集合同步参数数据

2、如果没有任务(para_task),则创建;如果任务和正式表存在,进行任务状态校验

3、如果临时表中有可修改的、显示在页面上的字段,则将这些字段值复制到etlData中

4、ETL数据覆盖到TEMP

5、记载审计日志

6、更新Etl表,设置ETL表的sync_st=1

本主题域从ETL同步后是否可编辑,即可以在多渠道进行维护部分字段,如果不可以在多渠道维护,那么自动生效

CommonParaSyncMainOperBean.activateSubject

做了几件事:

对需要自动生效的任务:

1、将para_task状态改为“复核通过”

2、syncService.activateTask(task);(CommonParaSyncServiceBean.activateTask)将状态改为5(生效中),设置一些ts和userid,做一些检查;forwardOthers()-》sendQueue()发送jms(类型是:ParaConstants.JMS_SUB_SYS_SYNC-JMS子系统同步)

3、ParameterEventBean.process()接受到这个jms消息开始处理:

sucess = syncExecute.activate(requestId);

参数同步生效方法

1.同步临时表数据至正式表

2.同步成功后,执行同步至其他子系统操作

4、if(sucess==true)并且该主题域是可以自动生效自动关闭的(entry_wizd_in=2),

那么设置任务状态是:"S", "同步成功",然后执行关闭任务:syncService.closeTask(task);(CommonParaSyncServiceBean.closeTask(ParaTask task))

备份一张表(ixf为二进制,del为字符型)

db2 "export to ./backup/ETL_MAMGM_TRANS_CHNL_CD.ixf of ixf select * from ETL_MAMGM_TRANS_CHNL_CD"

覆盖一张表

db2 "import from /maps/usr/ma_mgmdb/backup/ETL/ETL_MAMGM_TRANS_CHNL_CD.ixf of ixf insert into ETL_MAMGM_TRANS_CHNL_CD"

查询schema下所有表

list tables for schema "ZHAOWM"

select * from table fetch first 10 rows only;

select * from table where v_time = timestamp('2008-01-01-00.00.01.000000');

weblogic配置data sources时提示jdbc找不到。

解决:要把d2cc.jar拷贝到domain\lib下。

myeclipse有时会报找不到某一类的错误,但是实际上是能找到的。

解决:clean project

修改好的swf文件要放在这里:

\maps_mng\WebContent\com\cup\maps\portal\jpf\monitor\maps_monitor.swf

取路径的最后文件名并排序

sed 's/.*\///;s/.*\\//' 1 | sort >2

用室内CVS上的代码与研究院上的代码比较,按时间降序

PARA_SUB_AREA_INF

ENTRY_WIZD_IN: 该字段在java中使用。

0: 参数维护页面上有“任务创建”按钮;公参任务自动生效。

1: 参数维护页面上有“任务创建”按钮;公参任务执行在“录入中”状态停住。

2: 参数维护页面上没有“任务创建”按钮,只有“查询”;公参任务自动生效。

无论0还是1,在页面上手工创建任务时,都需要手工经历录入中,待复核,复核通过,同步正式表,同步成功等状态。

BAT_EFF_IN: 0:只读 1:可以新增、修改。 该字段在页面上使用

subject.as中存在该字段,如果0的话,“任务创建”按钮还是不存在的。如果是1的话,“任务创建”按钮会在的。

是否同步子系统:

para_tbl_attr:

ma_subsys_bmp 10位位图

每位顺序代表:联机(第一位),批量(第二位 ),通讯,管理,健康,NASA(第6位)

PUB_PARA_CD 该字段在公参同步时使用,当子表的该字段值为空时,该子表不做同步处理;当子表的该字段值为01,即有值时,该子表会同步数据。

表是否支持插入,更新,删除,查询

para_tbl_attr:

main_tp 4位 0表示可以做,1表示不可以做

para_tbl_attr的ini_exp字段,是页面初始化使用的字段

具体使用在:TableForm.as中(引用了ParaTable.as的initExp值,该值对应着上述字段)

字段

para_fld_attr:

readonly_bmp 两位,分别对应“新增/修改” 0表示具有这个权限,即具有新增或修改权限,1代表不具有该权限

Form_in: 一位, 1 表示 在创建参数修改任务中,在创建参数新增任务中,会显示这个字段; 0 表示 页面中不显示这个字段

SHOW_TP: 一位: 0 表示使用默认值,在CommonSyncCommand.copyUpdatableFields()中,会将TBL_MAMGM_PARA_FLD_ATTR表中配置的dft_value值,覆盖到etl表中。

LIST_IN: 1 表示在检索结果中,会显示这个字段

INQ_FLD_IN 1 表示在参数维护页面,检索时显示的条件项。 0表示该字段不在检索条件里。

COMP_TP 00 表示一般单行文字输入框, 01 表示下拉框 11 表示可以输入的下拉框 04 日期 07 时间 06 多行文本框

DRDL_VAL_TBL_NM 下拉框里面选择的内容。对应于TBL_MAMGM_DRDL_CFG表。

fld_data_tp:00:string 01:INT 02:timestamp 03:float 04:BIGDECIMAL

DFT_VALUE: 页面上新建参数任务时,该字段的默认值。

所有表的字段都会在TBL_MAMGM_PARA_FLD_ATTR中,但是并不是所有SHOW_TP为0的字段,都会被覆盖默认值,必须满足下面条件:

1、FORM_IN=1,该字段在页面上显示

2、READONLY_BMP = 10或00 (第二位是0) ,该字段可以修改

3、SHOW_TP为0

4、tmp表在etl表数据覆盖之前是没有值的。

任务提示

页面:todolist.mxml

页面初始化:ParameterFlexFacade。countTaskBySubject()。另:那个URL是在renderCountTaskList(taskGroup)方法中定义

点每个主题域链接:初始化中的链接,是取缓存access_inf表中的url。

这个表里的url,对技术参数而言是类似于parameter.jsp?subject=X;---》parameter.mxml-----> <taskView:Start> ----> 它指向Start.mxml---> 在parameter.mxml里有一个初始执行函数init()---》 调用执行 main.as里面的init()函数-----》调用startPage.init()---->调用Start.as里面的init()函数

进入主题域的参数维护页面:

1、“任务批次状态”、“任务生效状态”--->overview.mxml

"录入中"、“待复核”、“复核通过”、“复核不通过”--->ParameterFlexFacade。countTaskByStatus(),保存在response中的batchStatusCountList属性里

2、“同步正式表成功”、“同步正式表失败”。。。。--->保存在response中的effectStatusCountList属性里。

“同步子系统成功”、“同步子系统失败”、“部分同步共享内存” 三个按钮是否存在,是在ParameterServiceBean。countTaskByStatus(String subjectId)里面做了判断。因为有些表不需要同步子系统,另外一些表不需要同步共享内存。

3、点诸如“录入中”“待复核”等链接。是在overview.as里initQueryButtons()方法中设置了一个监听器,监听函数就是queryTask(),它又调用了ParameterFlexFacade.queryTaskByStatus()方法。

4、至于随之变化的底部的按钮,是在初始化时就保存好的。在点击诸如“录入中”“待复核”等链接并调用了

queryTask(),这个函数会调用initActionButtons()函数,会将初始化保存好的状态信息与各个按钮对应的显示在底部。

5、底部的按钮的action也是在初始化时就设置好的。由ParameterFlexFacade静态调用TaskStatusHelper.init(),这个方法将每个状态对应有多少动作按钮都设置好。会保存在response的statusMap属性里。

6、response中的actionMap属性保存的是涉及流程的操作类型,供之后处理,比如:删除,提交,复核通过,复核不通过等等。

7、switchPage在flex/ParamNew/main.as中定义,函数switchPage(event : MapsEvent)中执行,参数只有三种:OVERVIEW、PARA_QUERY、PARA_EDIT

8、“检索”按钮

9、“创建参数修改任务”和“创建参数删除任务”调用ParameterFlexFacade.queryProdPara(),查询主表和子表相关内容。

10、“创建参数新增任务”不需要查询记录。

11、任务状态“录入中”、“待复核”、“复核通过”等链接下面的按钮如“任务提交”、“任务查看”、“任务信息”、“任务修改”等是保存在response的statusMap里面,

且在ParameterFlexFacade.getGrantedActionMap()函数里面设置。

查询按钮是所有任务状态链接下都有的按钮。

"创建参数新增任务"\"创建参数修改任务"\"创建参数删除任务"按钮在Query.mxml页面中,点击按钮的触发的函数分别是gotoCreateInsert()、gotoCreateUpdate()、gotoCreateDelete()。

对于修改任务gotoCreateUpdate(在Query.as中):

1、校验是否选中一条记录:getSelectedRecId

2、执行checkOper("U"),调用checkParaOperatable(mainTable.tblId, getSelectedRecId())

3、执行回调函数checkParaOperatableHandler -》 getSwitchEvent("U",recid,eventid)-> ParamNew/main.as中定义的事件switchPage,traget=ParaConstants.PAGE_PARA_FORM

4、mainFrame.selectedIndex = 2;paraEdit.initParaPage(event.data);意思是页面展示Edit.mxml,并且执行Edit.as的initParaPage函数,函数参数是ParaUtil种定义的switchEvent的data

参数中包括target=“PARA_EDIT” type=“U” recId eventId这四个参数,

5、该initParaPage函数首先执行ParameterFlexFacade.queryProdPara()

6、执行回调函数queryParaHandler() -> shown() 多表的要加上多表 -》 showForm();表数据引入 -> reloadButtons()置入按钮

获取一开始的处理操作,即参数管理中每个表的初始进入页面中“查询”、“任务创建”。

这两个按钮是否存在的判断在:

ParameterFlexFacade.blankGrantedActionList()

1、该用户是否有这两个按钮的权限

2、该主题域是否具有可以查询,可以任务创建的功能。(TBL_MAMGM_PARA_SUB_AREA_INF.ENTRY_WIZD_IN)

3、点“任务创建”后,“创建参数新增任务”“创建参数修改任务”“创建参数删除任务”“查看参数”是由TBL_MAMGM_PARA_TBL_ATTR.MAIN_TP字段控制。位图1111表示上述四个按钮全都存在,0000表示上述四个按钮全不存在。

tmp表数据怎么来的?

1、从etl表读数据到一个rowset中

2、增加一些时间和人的信息

3、给特殊情况的字段赋默认值

商户路由表为什么单拿出来?

商户路由的etl表与tmp表表名不一致。tmp表和tbl表的表名一致。公参同步是将ETL_MAMGM_SETTLE_TRE_MCHNT_INF表(财税库银商户表,该表从商户平台来,且由商户平台发起同步命令)

的一部分内容同步到tbl_mamgm_mchnt_rout_det,另一部分内容同步到tbl_mamgm_mchnt_rout_inf(该表是主表)。

这两个表公参时特殊处理,不走优化后的公参代码。

卡号转换表没有etl表?

不是所有tmp,tbl表都有对应的etl表,etl是给公参同步时,外系统用的

公参同步的web services接口在:

BatchSynchResultNotifyImpl。notify()

这个方法调用EJB,EJB的名字是CommonParaJmsService,它又对应了CommonParaJmsServiceBean。sendJmsRequester()来处理

查看目录下文件或文件夹得大小,并按照从大到小排序

du -sg * |sort -nr

在VI中,将字符串str1替换成str2

:g/str1/s//str2/g

aix中vi一文件,删除^M符号,执行如下命令:

:%s/^V^M//

:%s/^M//

^V和^M指的是Ctrl+V和Ctrl+M

公参同步任务是如何执行的?

商户平台使用web services访问接口BatchSynchResultNotifyService,而这个类BatchSynchResultNotifyImpl又用ejb的形式调用了local接口CommonParaJmsService。并由CommonParaJmsServiceBean.sendJmsRequester()

通过CommonParaSyncRequester给JMS服务队列发送消息,MsgProperty是"common_para_sync"。

CommonParaSyncMDB 通过JMS消息队列 接收到这个消息后,把ObjectMessage转发给CommonParaSyncEventBean,由ObjectMessage中的MsgProperty决定,把ObjectMessage中包含的两个参数,一是参数类型,一是批次号。

发给CommonParaSyncMainOperBean。operEtl来处理

1、正在同步的公参批次,如果由另外一页面发起强制同步的话,很容易报911,表锁问题;原因在改ETL表的状态为1时与MERGE语句使用了相同的表。

2、公参成功后,查看的是紧接着的同参数类型的一个批次是否成功,如果是待同步,则执行,如果是成功的就不会往下做了。隔着的那些待同步批次不会执行的。

公共参数管理页面对应的jsp:

/com/cup/maps/portal/jpf/flex/CommonParaQuery.jsp

“重新同步”命令调用ParameterFlexFacade.reSyncCommonPara(String batNo,String paraTp,boolean force)函数。

该函数调用 CommonParaJmsService.sendJmsRequesterForce() 发送jms消息,(跟商户平台的公参同步类似,不过它走了另外一个函数sendJmsRequester)

“重新同步”与“强制同步”均要走同步正式表和生效接口,它们的不同在于:

1、“强制同步”无视 还小的批次号,可以绕过之前失败的批次做同步。

2、如果该批次同步成功,公参任务表的最终状态会改成“3-强制同步成功”

研究院-电话支付-CVS

:pserver:leishen@172.17.238.150:2401/cvsout

Module:tams

checkout某一标签tag的cvs文件:

cvs co -r branch_tipsp_codemerge_20120530 isvr_mgm

查看标签语句

cvs status -v

ant在编译指定文件夹中的java类时,会将该java类引用到的所有java类同时编译。

在打war时就可以把引用到的java生成的class文件一起打入war包中。

db2在某一列创建索引时会让你选择该列是否设置成unique。

对于显示的查询结果,如果要有水平的滚动条,需要修改这个dataGrid的属性,

增加一个:horizontalScrollPolicy="auto"

商户同步的参数中,也就下面表需要编辑。其它的都是自动生效的

卡bin 01010601 TBL_MAMGM_BIN+TBL_MAMGM_BIN_REGION 0000000000

机构信息(成员机构静态信息表) 01010101 TBL_MAMGM_INS_STATIC_INF 0000000000

商户类型表 01071101 TBL_MAMGM_MCHNT_TP 0000000000

交易代码表 01071401 TBL_MAMGM_TRANS_ID 0100000000

行业机构静态信息表:服务提供机构、渠道接入机构、行业商户

industry_ins_static_inf

成员机构信息表:多渠道平台、银联总分公司、转接机构、发卡机构、收单机构

ins_static_inf

商户静态信息表:直连终端商户、渠道接入机构商户、服务提供机构商户、行业商户、虚拟商户

mchnt_static_inf

终端静态信息表:直连POS、ATM、电话终端、各种虚拟终端

term_static_inf

对于“参数同步”这个交易,tbl_mamgm_para_tbl_attr中配置了两条记录如下:

TBL_CDTBL_NMTBL_NM_CNMA_SUBSYS_BMPSUB_CDENTRY_WIZD_SEQ

0803010208030102参数同步到数据库(返回)00010000000803011

0803010108030101参数同步到数据库(发送)11000000000803010

OnlCommon.getSTMGBySubCd(subjectId,subsysId);

该函数取ENTRY_WIZD_SEQ=0的记录,由subsysId(是BAT、ONL)来得到联机或者批量的默认节点

OnlCommon.getRTMG(subjectId);

该函数取管理的默认节点(节点的意思是tbl_maps_gfs_deploy_inf这张表的一条记录,包括ip,port,openid等信息)

批量应用重启:

taskcom stop all

停应用

MPubTask &

启动

管理数据库停止后,再开启,不影响管理应用继续使用,管理应用无需重启即可。

jdbc:db2://172.17.252.84:60032/mamgmdb

是ma_onldb/ma_onl用户建的。端口60032是这个用户在/etc/services文件设置好的。

ma_onldb@/etc>cat /etc/services |grep 60032

DB2_ma_onldb 60032/tcp

多渠道管理有5个web service 接口,页面上可以测试。CommonParaJmsServiceBean类是第一层处理接口:

1、公参管理

http://172.17.252.85:4866/maps_service/BatchSynchResultNotifyService?wsdl

http://172.17.252.63:7001/csb/shcenter/BillDomain/MultiAcquiringSystem/ParamSyncNotiry/ParamSyncNotiryProxy?wsdl

http://172.17.248.158:40423/maps_service/BatchSynchResultNotifyService?wsdl

http://172.17.248.40:4867/maps_service/BatchSynchResultNotifyService?wsdl

2、改变交易规则状态交易(changeFilterAppInf)

改变指定商户的交易状态(changeMchntTransSt)

改变指定终端的交易状态(changeTermTransSt)

根据任务事件号查询的事件状态(queryTransSt)

http://172.17.252.85:4866/maps_service/TransStateAndRuleSwtService

3、行业机构状态查询

http://172.17.248.74:8888/MapsServicePortal/IndustryInsStateActionService?wsdl

4、bps接口

http://172.17.248.74:8888/MapsServicePortal/BpsServiceImplService?wsdl

对应csb地址:

http://172.17.252.63:7001/csb/shcenter/BillDomain/MultiAcquiringSystem/BpsServiceImplService/BpsServiceImplServiceProxy?wsdl

5、多渠道交易状态查询接口(过滤应用信息表状态、商户状态、终端状态查询) 未上线

http://172.17.248.74:8888/MapsServicePortal/TransStateActionService?wsdl

6、供mtqj调用接口

http://172.17.248.74:11000/MapsServicePortal/MjcCallActionService?wsdl

7、手工交易

http://172.17.248.74:11000/MapsServicePortal/MjcCallActionService?wsdl

MTQJ的webservice地址

http://172.17.252.88:10000/mjc/MtqWebService?wsdl

行综平台管理系统目前有1个web service 接口

csb地址:http://172.17.252.63:7001/csb/shcenter/BillDomain/IntegratedServicePlatformForIndustry/IsvrBatchParaSynchNotifyService/IsvrBatchParaSynchNotifyServiceProxy

对应的行综环境:http://172.17.248.188:7004/IsvrServicePortal/BatchParaSynchNotifyService?wsdl

csb地址:

http://172.17.252.63:7001/sbconsole

用户名/密码:weblogic/weblogic

多渠道在Projects->csb->shcenter->MultiAcquiringSystem

行综在Projects->csb->shcenter->IntegratedServicePlatformForIndustry

通讯重启:

1、hgcom1/nasa/bin/reload_cfg 100 300 0 shutdown

2、mtqshutdown

3、mtqstartup

4、hgcom1/nasa/bin/nasad

5、shmadmin

5.1--- h

5.2--- create COMALL

5.3--- q

6、reload_cfg 100 300 0 start

7、ml

8、ps -ef |grep $USER

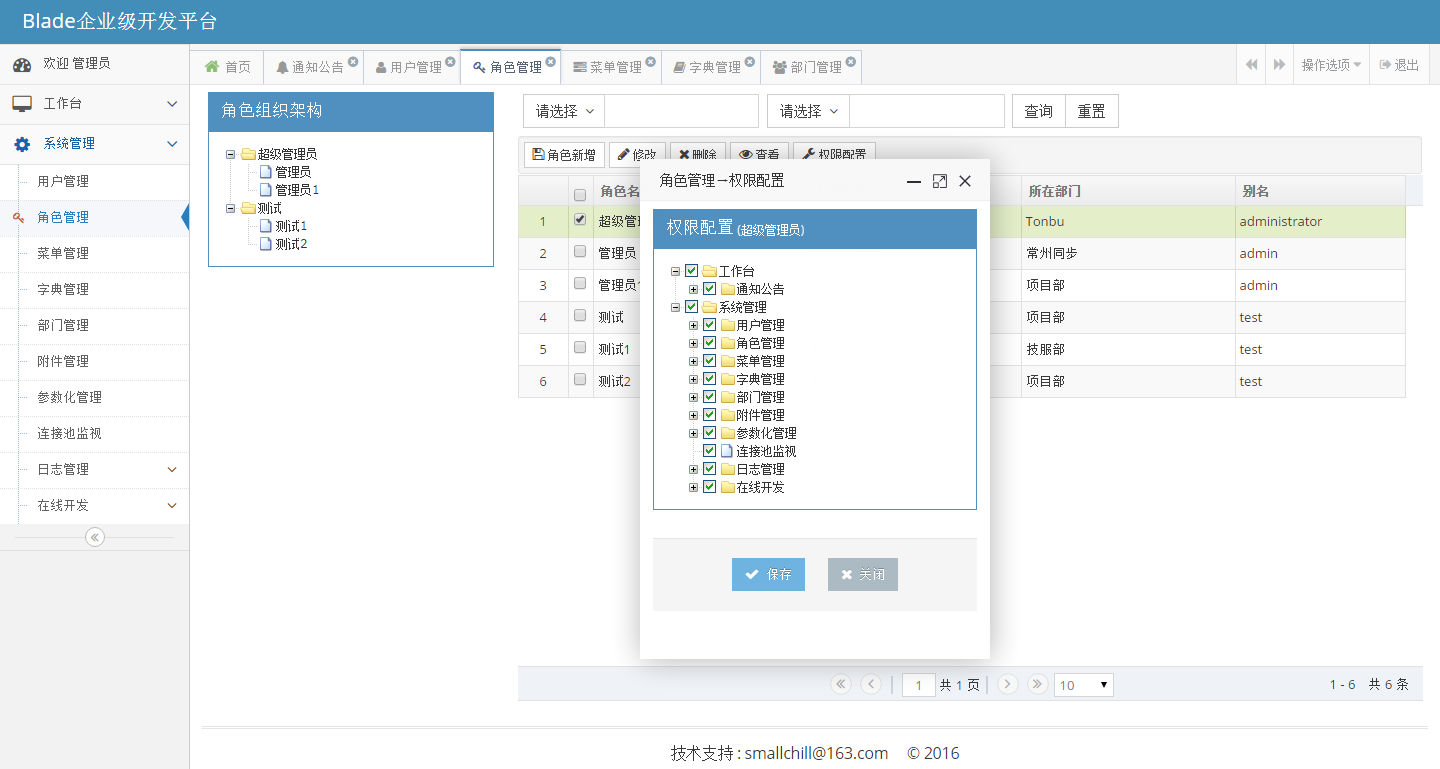

用户管理平台(权限相关):

系统权限导入:只会更新已有数据+插入新增数据。不会删除系统已有数据。

EJB3里面

@TransactionAttribute(TransactionAttributeType.NEVER)的函数中,调用了

@TransactionAttribute(TransactionAttributeType.REQUIRES_NEW)的函数,子函数的事务不起作用,无法回滚

bytes[]类型的参数同步后的数据与etl表原始数据不一致,最后部分的00 00 00内容被截断了,需要修复。

修改:SqlUtil.java下面这行

fieldValue = StringUtils.defaultString(new String(rowset.getBytes(fieldCount))); //byte[]的类型特殊处理

管理系统使用DBPM

自己开发一应用程序,用modifyPasswd.sh执行,读取config.properties配置的DBPM服务器地址,通过socket的方式获得数据库密码。

然后调用调用WLST工具类,修改Domain中的JDBC数据源中设置的密码。

然后启动domain。

下面5个交易由之前的同步交易,改成异步交易,发送流程是:首先管理发MTQ消息给联机1,联机1通过通讯发给CUPS,cups做完后会返回结果给联机,但是由于通讯是负载均衡的,所以有可能发给了联机2,联机2通过异步邮箱134, 发送给管理,管理得到134邮箱的内容后,会更新联机交易日志表(manage_trans_log),此时管理端仍然在轮询联机日志表,找到状态是1(收到事件请求报文),2(已经事件处理完毕),99(出错)的对应event_id记录后,返回前台成功或出错信息,如果超过60秒,仍然没有找到,那么返回前台超时标志。

签到:多渠道向cups签到,激活状态。

签退:多渠道向cups签退。

申请重置密钥:通知cups,让cups给成员机构发送密钥。

重置密钥下发:通知行业机构重置密钥

线路测试:通知cups,让cups给成员/行业机构发送测试交易。

终端签到:

先去查联机的终端静态表,如果状态为1-冻结,直接报错,如果状态为0,接着校验交易位图等,最后更新联机终端动态表状态为0-开启。

终端状态启用冻结

只更新联机的终端静态表

查找主题域/表对应的下拉框的内容:

select t5.sub_cd,t5.SUB_NM_CN,t4.TBL_CD,t4.TBL_NM_CN,t1.*

from TBL_MAMGM_DRDL_ITEM_DEF t1,TBL_MAMGM_DRDL_CFG t2,

tbl_mamgm_para_fld_attr t3,tbl_mamgm_para_tbl_attr t4,TBL_MAMGM_PARA_SUB_AREA_INF t5

where t1.DRDL_ID = t2.DRDL_ID and t2.DRDL_NM = t3.DRDL_VAL_TBL_NM

and t3.tbl_cd = t4.TBL_Cd and t4.SUB_CD = t5.SUB_CD

and t4.TBL_CD = '07010301'

and t5.SUB_CD = '070103';

公参同步用到的一系列表:

select * from TBL_MAMGM_PARA_SYNC_TASK;

select * from TBL_MAMGM_PARA_TASK;

select * from TBL_MAMGM_ACCESS_INF;

select * from TBL_MAMGM_PARA_SUB_AREA_INF;

select * from TBL_MAMGM_PARA_TBL_ATTR;

select * from TBL_MAMGM_PARA_FLD_ATTR;

取得当前时间:

select current timestamp from (values 1);

取得sequence的下一取值:(两种方法)

select nextval for sqn_mamgm_ei from (values 1);

select nextval for sqn_mamgm_ei from sysibm.dual;

values nextval for sqn_mamgm_ei;

设置管理数据库的REC_ID对应的sequence下一取值为108000003

alter sequence ma_mgmdb.sqn_mamgm_ri restart with 8000003

CHAR型转INTEGER

select CAST(INS_ID_CD AS INTEGER) max from etl_mamgm_ins_static_inf;

TBL_MAMGM_PARA_FLD_ATTR表中配置的字段如果少于TBL表中的字段,在创建新增参数任务、创建修改参数任务时都会报错。

具体表现为:

1、关闭记录时tmp记录删不掉。

2、修改参数任务时也没显示的字段值不对应。

下拉框配置表TBL_MAMGM_DRDL_CFG:

DRDL_TP: 2 表示用sql执行的结果,进入页面时,读数据库一次下拉框的代码

DRDL_REMARK:sql语句

SHOW_KEY_IN: 0 表示格式像“代码中文名称” 1 表示格式像“代码-代码中文名称”

DRDL_SORT_TP: 1

JMS server参数配置:

Messages Maximum: -1。 JMS消息队列最大值。设为-1表示没有限制,容易引起内存不足。

Maximum Message Size:2147483647 The maximum number of bytes allowed in individual messages on this JMS server

虚拟终端确定信息表TBL_MAMGM_VIRTUAL_TERM_DET的ETL表比TBL表多一个字段CUP_BRANCH_INS_ID_CD,此时无论公参优化前后,该表都可以同步成功。

但是如果公参同步失败,需要页面上人工操作,走参数维护流程,那么将出错,

出错情况和上面所讲的TBL_MAMGM_PARA_FLD_ATTR表中配置的字段如果少于TBL表中的字段情况相同。

目前多渠道代码的问题缺陷错误:

1、TBL_MAMGM_DRDL_ITEM_DEF.drdl_id=9254名称写错:“本平手工台录入”

2、商户黑名单etl_MAMGM_MCHNT_BLKBILL没有sync_bat_no字段,无法做公参同步,报错。好在这个表联机批量都不用。

3、中奖奖项限制配置表TBL_MAMGM_PRIZE_LIMIT_CFG该表没有ETL表,但是该表是子表且pub_para_cd值为空,该表不做同步处理,公参同步时不报错。

4、子表被删除了,在页面中通过主表查询子表内容还是能看到。

5、下拉框表TBL_MAMGM_DRDL_CFG中,WINUSEFLG有2个。

java的substring问题

String ss = "1234567890123456";

System.out.println(ss.substring(1,2));//2

System.out.println(ss.substring(2,4));//34

System.out.println(ss.substring(5,8));//678

在参数删除时,不对字段进行校验

ParameterFlexFacade.checkParaByValidators()根据Validator进行校验

新建“链路信息表”记录时,输入“链路编号”字段,只有两位,保存到TMP表以后,该字段变成13位,原因:

TBL_MAMGM_PARA_TBL_ATTR配置表时,BEFORE_INSERT_EXP字段配置了处理代码,如下:

import com.cup.maps.parameter.util.*;

String s=map.get("LINE_NO"); if (s.length()==2)

{ map.put("LINE_NO",map.get("ACCESS_INS_ID_CD")+s);

ParaExpressions.checkExistRecordForTask("01100701", map); }

此外该表在TBL_MAMGM_PARA_VFY中有很多校验信息,具体有15条,列出如下:

无效的接入系统标识!

链路编号C开头本方监听端口应为0

链路编号A开头本方监听端口不为0

链路编号C开头对方监听端口不为0

链路编号A开头对方监听端口应为0

本方监听端口输入错误!

对方监听端口输入错误!

登录用户不能为空

登录密码不能为空

短信窗口大小不能为空

短信源发序列号不能为空

短信接入角色不能为空

检测时间间隔不能为空

单条链路超时时间不能为空

接入模式 0001 /0006,才能选支持

在管理应用上部mtq时,除了常规参数配置外,还要保证/glb/mtq/etc/mtq.ini文件中

SHMKEY_MB和MSGKEY这两个参数,在应用主机上与其他用户的mtq配置的不重复。

用winrar软件更新jar文件中的一个class,压缩进去,生成的新的jar文件,仍然可以像之前一样引用,且更新的地方也会生效。

假如程序A.java引用了XX.JAR包中的B.java,且B.java又引用了XXX.JAR中的内容。那么:

1、把B.java打成XX.jar包的操作,不应该将XXX.JAR打入XX.JAR中

2、在javac A.java时,classpath应该只包括XX.jar和.

3、在执行java A.java时,应该将XX.JAR和XXX.jar均包进classpath中。

例子Testjar.java中引用了tools.jar的XmlRead类,而XmlRead类又引用了dom4j-1.5-rc1.jar包的内容,下面是正确编译和执行的语句:

D:\>javac -classpath "d:/tools.jar" Testjar.java

D:\>java -classpath ".;d:/tools.jar;D:/workspace/TOOLS/lib/dom4j-1.5-rc1.jar" Testjar

下面两个sql,第一个取全部字段,走全表扫描,第二个sql由于取主键,走索引。两边取出的值不一定一样。

select * from ETL_MAMGM_TERM_STATIC_INF where sync_bat_no = 999 fetch first 1000 rows only with ur;

select term_id,mchnt_cd,sync_bat_no from ETL_MAMGM_TERM_STATIC_INF where sync_bat_no = 999 fetch first 1000 rows only with ur;

商户折扣信息表,中奖等级表,中奖基本表等按照规划是营销平台通过公参平台公参同步到多渠道,但是营销平台没有这些接口,

多渠道本身也没有用这些表。

商户黑名单和卡号黑名单这两张表是在商户维护的吗?

答:是风险平台维护。但现在他们还没有作

mtq.ini中有:

BEGIN GROUP

31 172.17.252.87 8113 20 S

END GROUP

mtq重启以后,端口8113会被监听

netstat -an|grep 8113

查看当前用户的进程

ps -ef |grep mtq|grep $USER

BEGIN GROUP里面的配置的S要大写。

0 172.17.248.57 8100 20 S这个0的行是什么含义?

异步邮箱组连接数及发送报文个数:

mtqmng list或者ml(需要创建别名alias ml="mtqmng list")

su - iisp1onl

iisp1onl@/iisp/usr/iisp1onl>db2 connect to ISMGMDB user iisp1db using iisp1db

db2 reorg table ma_mgmdb.TBL_MAMGM_MSG_FMT_CONV_MTO

多渠道管理回归数据库82

telnet 172.17.252.82

su - ma_mgmdb

db2 list db directory

/maps/usr/ma_mgmdb>db2 connect to GMAMGMDB user ma_mgmdb using ma_mgmdb

db2 reorg table ma_mgmdb.etl_mamgm_mchnt_static_inf

db2 reorg table ma_mgmdb.tmp_mamgm_mchnt_static_inf

db2 reorg table ma_mgmdb.tbl_mamgm_mchnt_static_inf

查询db2错误代码

db2 ? sql-30082|more

82联机回归数据库,发生668错误

maps/usr/ma_mgmdb>db2 connect to GMAONLDB user ma_onldb using ma_onldb

db2 runstats on table ma_mgmdb.TBL_MAMGM_AUDIT_LOG2

/maps/usr/ma_mgmdb>db2 reorg table TBL_MAONL_MCHNT_STATIC_INF

获取前台flex发送到后台的值

OnlCommon.getSentFlied(String subjectId, Map<String, String> map)

根据主题域ID取到参数表对象列表

OnlCommon.java List<ParaTable> getParaTable(String subjectId)

过滤应用信息的下拉内容来源于业务参数(fml域转换配置信息表),

成员机构静态信息表在页面上做“创建参数修改任务”后,复核通过,会在同步正式表成功那里卡住,

然后在“参数刷新-参数同步到共享内存”页面做了参数刷新以后,回到参数管理页面,该参数已在同步成功栏内。

刷新共享内存及更新para_task状态的地方在:SyncExecuteBean.refreshSchemeStatus(Map<String, String> map)

这里面maps的内容是子系统subsysCd和内存编号zoneId

这个函数做了两件事:

1、更新TBL_MAMGM_PARA_TASK_SYNCSHM_STATUS状态为4-成功

2、更新TBL_MAMGM_PARA_TASK为S-同步成功或者A-部分同步到共享内存成功

同步子系统的地方:

ParaSyncServiceBean。sendMsg(ParaTask batch, Map<String, String> map)

需要的内容包括:batch里面的eventid,map里面的子系统名称、多个表名

db2取当前时间

SELECT current date FROM SYSIBM.DUAL;--取得当前年月日

SELECT current time FROM SYSIBM.DUAL;--取得当前时分秒

SELECT current timestamp FROM SYSIBM.DUAL;--取得当前年月日时分秒

select current timestamp,microsecond(current timestamp) from SYSIBM.DUAL;

select 1,to_char(current timestamp,'yyyymmdd') from sysibm.dual;--日期格式

axis,unix取当前时间

dateWed Mar 9 11:22:07 GMT+08:00 2011

date +%Y2011

date +%y11

date +%m03

date +%M22

date +%d09

date +%D03/09/11

date +%S07

date +%s1299669809

错误:

DB2 SQL error: SQLCODE: -20154, SQLSTATE: 23513, SQLERRMC: MA_MGMDB.VIW_MAMGM_AUDIT_LOG;2

sqlcode-20154原因:指定的视图包含一个UNION ALL查询

1、不符合任何基础基表的检查约束。

2、满足所有多个基础基表检查约束。

解释:视图VIW_MAMGM_AUDIT_LOG是由TBL_MAMGM_AUDIT_LOG1和TBL_MAMGM_AUDIT_LOG2这两个表组成的。在这两张表的create时,

没有增加CHECK (SUBMIT_MON BETWEEN 1 and 6)和 CHECK (SUBMIT_MON BETWEEN 7 and 12)语句,导致在insert viw时,db2不知道要插入哪张表。

db2 修改字段属性

alter table tmp_maps_gfs_fmt_grp alter trantype set data type char(6);

select current schema from sysibm.dual

db2 values current schema

菜单的顺序是跟access_inf表的event_id相关的。只有event_id相同的情况下,才看access_cd.

unix vi命令

01 G 移至最后一行行首

02 nG 移至第n行行首

03 n+ 下移n行,行首

04 n- 上移n行,行首

05 n$ 下移n行(1表示本行),行尾

06 0 所在行行首

07 $ 所在行行尾

08 ^ 所在行首字母

09 h,j,k,l 左移,下移,上移,右移

10 H 当前屏幕首行行首

11 M 屏幕显示文件的中间行行首

12 L 当前屏幕最底行行首

管理系统里面不常用的两个sequence:

TBL_MAMGM_FLOW_CD的主键Sequence

public static final String TBL_MAMGM_FLOW_CD_KEY="sqn_mamgm_fck";

审计日志sequence

public static final String AUDITLOG_SEQUENCE = "sqn_mamgm_aui";

db2中select语句最多可以选择1012个字段,超过以后就会报sqlcode=840的错误。说选择的列太多。

ultraedit每行最多显示4096个字符

感觉db2的sql长度没啥限制一个18k的select语句也是可以被执行的。

如果select出来一个字段没有值,那么rs.getString()取出来的值是空:"",并不是null

我们的页面根本没有对用户的权限做限制,比如:

在url上输入:https://172.17.252.85:8889/maps/com/cup/maps/portal/jpf/flex/cacheRefresh.jsp

然后再登录的地方输入分公司的用户名和密码

页面仍然可以显示,并且刷新的功能也能完成。

查看aix的版本

oslevel

将System.out.println输出到文件中。

OutputStream os = new FileOutputStream("d:/output.txt");

PrintStream p = new PrintStream(os);

System.setOut(p);

System.out.println("ee");

从jar文件中读取资源文件

//方法一,直接读取该文件的每行内容

BufferedReader br1 = new BufferedReader(new InputStreamReader(

((ReadXmlFileFromJar.this.getClass().getResourceAsStream("1.txt")))));

String s1;

while((s1=br1.readLine())!=null)

System.out.println(s1);

//方法二,读取xml文件内容后组装成document对象

BufferedReader br = new BufferedReader(

new InputStreamReader(((ReadXmlFileFromJar.this.getClass()

.getResourceAsStream("1.xml")))));

String s;

while ((s = br.readLine()) != null)

System.out.println(s);

SAXReader saxReader = new SAXReader();

Document document;

try {

document = saxReader.read(ReadXmlFileFromJar.this.getClass()

.getResourceAsStream("1.txt"));

Element incomingForm = document.getRootElement();

String ss = document.asXML().toString();

System.out.println("ss=" + ss);

} catch (DocumentException e) {

e.printStackTrace();

}

从jar中读取资源文件

1、方法一

URL fileURL=this.getClass().getResource("/resource/res.txt");

System.out.println(fileURL.getFile()); //file:/C:/ResourceJar.jar!/resource/res.txt

2、方法二

InputStream is=this.getClass().getResourceAsStream("/resource/res.txt");

BufferedReader br=new BufferedReader(new InputStreamReader(is));

String s="";

while((s=br.readLine())!=null)

System.out.println(s);

参数查询角色功能代码 :1001999014

是指参数维护页面上那个查询按钮

下面这条sql的执行计划是:

1、首先执行4)中的子查询,IXSCAN

2、然后执行3)查询表TBL_MAPS_GFS_TASK,TBSCAN

3、对1、2的查询结果进行HSJOIN,从而获得了行号ROWNO_以及t.*

4、对查询的结果进行排序bmqid

5、选取前40行记录

1)SELECT ROW_NUMBER() OVER() AS ROWNO_, t.*

2)FROM TBL_MAPS_GFS_TASK t

3)WHERE OPER_IN != 'd'

4)AND (node_id in (select NODE_ID from TBL_MAPS_GFS_DEPLOY_INF where SUBSYS_CD='BAT'))

5)order by bmqid

6)FETCH FIRST 40 ROWS ONLY

下面这条sql不同的地方就是第4)行,但是db2的执行计划就变成了:

因为node_id是索引查询,3)、4)、5)条件一起执行,IXSCAN,

然后再获得排完序的行号ROWNO_

1)SELECT ROW_NUMBER() OVER() AS ROWNO_, t.*

2)FROM TBL_MAPS_GFS_TASK t

3)WHERE OPER_IN != 'd'

4)AND (node_id in ('21','22'))

5)order by bmqid

6)FETCH FIRST 40 ROWS ONLY

DB2存储主键的地方

select * from SYSIBM.SYSKEYCOLUSE;

select * fROM sysibm.SYSINDEXES;--存储索引

select * from sysibm.syscolumns;--存储字段

select * from sysibm.systables;

select * from SYSIBM.SYSTABLESPACES;

select * from sysibm.sysschemata;

java中读取下拉框内容:

TransMonitorFacade.getDrdp(String name, false)

数据库中DECIMAL (8,2)

表示的意思是:

小数点前的位数最多是6位,小数点后的位数一定是2位,不够的话补0

appCfg/config.properties文件中的provider_url是给管理系统自己的webservice用的EJB接口

ajax发送到后台的字符编码与form提交使用的字符编码不同

正确的代码:

javascript:GET方式

var phone = document.getElementById("phone").value;

var url = "<%=request.getContextPath()%>/upload?phone=" + (phone);

url = encodeURI(url);

req.open("GET", url, true);

req.onreadystatechange = updatePage;

req.send(null);

java:

String phone = request.getParameter("phone");

phone = new String(phone.getBytes( "ISO-8859-1"), "UTF-8");

//设置响应内容类别

response.setContentType("text/html;charset=UTF-8");

response.setCharacterEncoding("UTF-8");

//传回浏览器

response.getWriter().println("i know your phonedddd d的上少时诵诗书 : "+phone);

//不需再forward

javascript:POST方式

var xmlString = document.getElementById("phone").value;

xmlString = encodeURI(xmlString);

var url = "<%=request.getContextPath()%>/uploadxml";

req.open("POST", url, true);

// Tell the server you're sending it XML

req.setRequestHeader("Content-Type", "text/xml");

// Set up a function for the server to run when it's done

req.onreadystatechange = confirmUpdate;

// Send the request

req.send(xmlString);

java端后台,接受XML格式 + POST方式,乱码解决:

StringBuffer xml = new StringBuffer();

String line = null;

BufferedReader reader = request.getReader();

while((line=reader.readLine())!=null)

xml.append(line);

String temp = xml.toString();

temp = java.net.URLDecoder.decode(temp, "UTF-8");

//设置响应内容类别

response.setContentType("text/html;charset=UTF-8");

response.setCharacterEncoding("UTF-8");

//传回浏览器

response.getWriter().println("i know your phonedddd d的上少时诵诗书 : "+temp);

浏览器访问链接上有中文时,如http://localhost/import/dbpatch?ss=aaa东东东东dd,浏览器会转成如下链接:

http://localhost/import/dbpatch?ss=aaa%B6%AB%B6%AB%B6%AB%B6%ABdd

doGet方法中有两种方式获取:

1、String query = request.getQueryString();

System.out.println("query="+query);//ss=aaa%B6%AB%B6%AB%B6%AB%B6%ABdd

query = java.net.URLDecoder.decode(query, "gbk");//直接访问的servlet

System.out.println("query2="+query);//ss=aaa东东东东dd

2、String ss = new String(request.getParameter("ss").getBytes("iso8859-1"),"gbk");//说明requst.getParameter方法做了转码decode

System.out.println("@@@@@@@ss="+ss);

DB2

如果一个字段设置为NOT NULL 但是没有默认值。比如如下语句:

CREATE

TABLE a

(

MSG_SPEC_TP CHARACTER(4) DEFAULT ' ' NOT NULL,

INS_ID_CD_CAPTURE_MD CHARACTER(1) NOT NULL,

INS_ID_CD_CAPTURE_EXPRESS VARCHAR(152) NOT NULL,

RID CHARACTER(10) DEFAULT ' ' NOT NULL,

CONSTRAINT TIX_MAMGM_MIT_PK PRIMARY KEY (MSG_SPEC_TP)

);

那么在INSERT记录的时候,就必须带上该列,

甚至可以在该列的VALUES里面填'',当然不能不填或者填个NULL

正确:INSERT INTO a(MSG_SPEC_TP,INS_ID_CD_CAPTURE_MD,INS_ID_CD_CAPTURE_EXPRESS)VALUES('5555','','');

(注:执行上述语句后,VARCHAR类型的字段值是'',而CHAR类型的字段值是' ',多一个空格,是DB2数据库自动添加的值。)

错误:INSERT INTO a(MSG_SPEC_TP,INS_ID_CD_CAPTURE_MD,INS_ID_CD_CAPTURE_EXPRESS)VALUES('5555',,'');

错误:INSERT INTO a(MSG_SPEC_TP,INS_ID_CD_CAPTURE_MD,INS_ID_CD_CAPTURE_EXPRESS)VALUES('5555',null,'');

错误:INSERT INTO a(MSG_SPEC_TP,INS_ID_CD_CAPTURE_MD)VALUES('5555','');

错误:INSERT INTO a(MSG_SPEC_TP,INS_ID_CD_CAPTURE_EXPRESS)VALUES('5555','');

如果这个列有默认值,那么INSERT语句就可以不出现该字段,比如上述的正确语句中就没有RID字段。

在FLD_ATTR中字段名配置为小写,不影响其在页面上进行录入,但是查询的时候字段值会显示不出来。

从cache中读取下拉框的值

List<Map<String, String>> ParameterFlexFacade.getDropdownListByFld(String fldCd)

TBL表中重复的EVENT_ID也没有关系

同步正式表的操作:ParaSyncServiceBean.activate。从batch取出的event_id是从TMP表中取得记录,然后根据记录的主键值

更新TBL中的记录。

appCfg/securityClient.properties文件详解:

defaultSSOUrl=http://172.17.249.56:6008

##maps ip

172.17.252.85=http://172.17.248.56:6008

##F5 ip

172.17.248.31=https://172.17.248.31:1215

Remote_NewSecurityEJB_Url=t3://172.17.248.56:6008

##maps system str assigned by sso

SysIdStr=6018724E9A708E13CB0156465E8E8384

isPortalLogin=false

loginClassName=com.cup.portal.security.utils.CupPortalSecurityUtil

如果Remote_NewSecurityEJB_Url这个配错了的话,重启后登陆会报如下错误:

Caused by: java.net.UnknownHostException: 172.17.258.56

at java.net.InetAddress.getAllByName0(InetAddress.java:1275)

at java.net.InetAddress.getAllByName(InetAddress.java:1197)

at java.net.InetAddress.getAllByName(InetAddress.java:1119)

at weblogic.rjvm.RJVMFinder.getDnsEntries(RJVMFinder.java:409)

at weblogic.rjvm.RJVMFinder.findOrCreate(RJVMFinder.java:180)

at weblogic.rjvm.ServerURL.findOrCreateRJVM(ServerURL.java:153)

at weblogic.jndi.WLInitialContextFactoryDelegate.getInitialContext(WLInitialContextFactoryDelegate.java:352)

... 24 more

com.cup.newSecurity.exception.LdapBaseException:

at com.cup.securityClient.client.service.UserService.getLoginUserAndPrivileges(UserService.java:95)

at com.cup.maps.portal.common.filter.SessionFilter.doFilter(SessionFilter.java:66)

at weblogic.servlet.internal.FilterChainImpl.doFilter(FilterChainImpl.java:42)

at com.cup.maps.portal.common.filter.SetCharacterEncoding.doFilter(SetCharacterEncoding.java:64)

at weblogic.servlet.internal.FilterChainImpl.doFilter(FilterChainImpl.java:42)

at edu.yale.its.tp.cas.client.filter.CASFilter.doFilter(CASFilter.java:221)

at weblogic.servlet.internal.FilterChainImpl.doFilter(FilterChainImpl.java:42)

at weblogic.servlet.internal.WebAppServletContext$ServletInvocationAction.run(WebAppServletContext.java:3496)

at weblogic.security.acl.internal.AuthenticatedSubject.doAs(AuthenticatedSubject.java:321)

at weblogic.security.service.SecurityManager.runAs(Unknown Source)

at weblogic.servlet.internal.WebAppServletContext.securedExecute(WebAppServletContext.java:2180)

at weblogic.servlet.internal.WebAppServletContext.execute(WebAppServletContext.java:2086)

at weblogic.servlet.internal.ServletRequestImpl.run(ServletRequestImpl.java:1406)

at weblogic.work.ExecuteThread.execute(ExecuteThread.java:201)

at weblogic.work.ExecuteThread.run(ExecuteThread.java:173)

java文件中:

String s = "工作就";

使用各种编码进行javac,语句如:javac -encoding GBK TestString.java

然后class文件中这三个汉字如何显示。

iso8859-1

String s = "\271\244\327\367\276\315";

默认编码

String s = "\u5DE5\u4F5C\u5C31";

GBK

String s = "\u5DE5\u4F5C\u5C31";

UTF-8

String s = "\uFFFD\uFFFD\uFFFD\uFFFD\uFFFD\uFFFD";

编成class文件以后,这个字符串的长度,就是用length()函数得到的长度就比较好理解了。

用iso8859-1编码进行编译后执行length()函数得到的长度是6,gbk编码进行编译的长度是3,utf-8编码进行编译的长度也是6。

注:

java中byte使用1个字节(8 bit)表示,char使用2个字节(16bit位)来表示。

还可以按某种编码来执行,如下:

java -Dfile.encoding=ISO8859-1 TestString

查看哪个进程绑定哪个邮箱

mtqmng pid

管理应用上的mtq是为了异步邮箱而安装的,生产上面两台管理应用就有两台MTQ,其中mtq2没有作用。

因为第二台管理上getmsgservice这个线程在启动时,读取deploy_inf表中的管理MGM默认节点,所以会与mtq1的134邮箱绑定。

同步模块在往管理发的时候也仅仅发送31号管理应用,也即第一台管理。

在Unix下获取多个IP的方法

ifconfig -au |grep inet |grep -v inet6 |grep -v 127.0.0.1 |awk '{print $2}'

EVENT_ST:事件状态

0-交易已发送

1- 交易被接受

2 - 交易已处理

99-交易出错

RESP_CD:请求应答码

00 - 成功

01 - 失败

99 - 确认收到请求/应答报文

response.code:返回报文中的应答码

00 -交易成功

XX-交易已接受

其它 - 交易失败

记联机交易日志MANAGE_TRANS_LOG时,首先根据逻辑一得出EVENT_ST:

if response.code == 00

EVENT_ST = 2

else if response.code == XX

EVENT_ST = 1

else

EVENT_ST = 99

然后根据逻辑二得出RespCode:

if ("99".equals(EVENT_ST)) {

tmmtl.setRespCode("01");

} else if ("2".equals(EVENT_ST)) {

tmmtl.setRespCode("00");

} else if ("1".equals(EVENT_ST)) {

tmmtl.setRespCode("99");

}

但是,在读取异步邮箱的代码GemMsgService中,却忘记了逻辑二,

直接将response.code中的代码更新到联机交易日志MANAGE_TRANS_LOG的RESP_CD字段。

删除子表记录:应该在创建修改任务中,再选择新增、修改、删除子表记录。

172.17.252.85上ma_mgm用户/mgmtest目录有最大50m的限制。

可以在console中的Security Realms->myrealm->users and groups ->点用户->passwords->save,

然后修改/mapsDomain/servers/MapsServer/security/boot.properties,这样该用户的登录weblogic的密码就改好了。

但是,改完之后执行stopWL.sh的时候报错,说密码错误。要改动bin/stopWebLogic.sh把其中的password改成正确的。就可以关掉weblogic了(或者删除也可以)

反编译资源文件

native2ascii -reverse -encoding gbk MessageResources.properties MessageResources_cn.properties

查看AIX系统资源

cpu:

vmstat(lcpu=8逻辑cpu有8个)

prtconf( Number Of Processors: 4 ==》物理cpu有4个)

查看系统使用情况 topas

查看aix内存svmon -G

例:

size inuse free pin virtual mmode

memory 2621440 2612781 8659 640841 3284826 Ded

pg space 1048576 898467

单位是4k,memory是实际物理内存:2621440*4/1024/1024=10g,

pg space是换页空间大小:1048576*4/1024/1024=4g

aix上查看java进程所占内存

svmon -P pid

例:

svmon -P 52363278

-------------------------------------------------------------------------------

Pid Command Inuse Pin Pgsp Virtual 64-bit Mthrd 16MB

52363278 java 132076 7764 5865 158615 Y Y N

进程实际使用内存Inuse:132076*4/1024 = 516M

查看AIX系统资源

prtconf

逻辑cpu

topas

bindprocessor -q

vmstat

物理cpu

prtconf

查看cpu的详细信息,如主频,是否支持SMT,是否开启了SMT等等

lsattr -El proc0

查看网卡相信信息,网卡ent0

netstat -v ent0

Eclipse @override报错

在JAVA 1.5和1.6中@override的用法是有些区别的,虽然改变了JRE但eclipse还是会报错。

解决办法:Windows->Preferences-->java->Compiler-->compiler compliance level设置成6.0就OK了

weblogic.xml中 weblogic-web-app 标签的 xsi:schemaLocation 属性,在myecplise下面报错如下:

Referenced file contains errors (http://www.bea.com/ns/weblogic/weblogic-web-app/1.0/weblogic-web-app.xsd). For more information, right click on the message and select "Show Details..."tips/tamcx/WEB-INFweblogic.xmlline 1131191929944315159

解决办法,在xsi:schemaLocation属性增加一段内容,如下:

http://java.sun.com/xml/ns/javaee

myeclipse6.0.1注册码生成:

TOOLS/MyEclipseGen.java执行后,输入名字就可以生成序列号。比如:

用户名shenlei

序列号Serial:fLR8ZC-855575-69527357679415182

myeclipse中js乱码问题,我导入项目后,发现js里的中文全部变成乱码

解决办法:

window->Preferences->Myeclipse->Files and Editors->JSP(以及javascript等)把encoding改成UTF-8。

workshop的webservice项目无法generate wsdl文件解决:

右键项目 Targeted Runtimes,勾上:Runtimes Oracle weblogic server v10.3

workshop中创建webservice工程,它的web.xml文件与weblogic.xml文件

与它export出的war包中的两个文件有所不同,需注意。

因为export出的war包中必须包括一些application启动类的配置。

行业机构静态信息表TBL_MAMGM_INDUSTRY_INS_STATIC_INF内的

INDUSTRY_INS_ST机构状态字段,0表示打开,1表示关闭

而对应联机库 TBL_MAONL_INDUSTRY_INS_DYN_INF表中的INDUSTRY_INS_ST字段 0表示关闭,1表示打开

workshop appxray编译时间过长解决:

右键工程——》properties->builders——》去掉勾选 workshop AppXRay

List<Map<String, String>> list = ms.findAllBySql(sql.toString(),

values);

这个方法竟然把我sql里面的列全变成大写字母放入MAP中

db2 创建远程节点连接

http://www.ibm.com/developerworks/cn/data/library/techarticles/0301chong/0301chong2.html

db2 catalog tcpip node mpwrnode remote mpower.ca.ibm.com server 50000

注: “mpwrnode”是为该节点所选择的任意名称。

mpower.ca.ibm.com = 数据库服务器 的主机名。 可以使用 IP 地址来代替主机名。

50000 = 数据库服务器实例 所使用的端口。

db2 catalog db a42ds1 at node mpwrnode

db2 connect to a42ds1 user <userid> using <password>

这样就可以再本地使用远程数据库。

例子如下:

1、db2 catalog tcpip node isvrfffffffff remote 172.17.248.188 server 60020

2、db2 catalog db ismgmdb at node isvrfffffffff

3、db2 terminate

4、db2 connect to ismgmdb user isvrdb3 using isvrdb3

删除catalog

db2 uncatalog node isvrfffffffff

在91ma_mgm上建的catelog,指向联机性能库

db2 catalog tcpip node maonldb remote 172.17.252.133 server 60000

db2 catalog db maonldb at node maonldb

db2 terminate

db2 connect to maonldb user ma_onldb using ma_onldb

当前用户的当前实例

db2 get instance

The current database manager instance is: ma_mgmdb

查看当前实例是否在

db2pd - -alldbpartitionnum

Database Partition 0 -- Active -- Up 129 days 07:30:50 -- Date 05/18/2012 17:02:26

查看活动日志使用如下命令:

db2pd -db arc -logs

当前实例的配置

db2 get dbm cfg

数据库的配置

db2 get db cfg for DBNAME

修改日志文件大小:db2 update db cfg for mamgmdb using LOGFILSIZ 40960

修改主日志文件个数:db2 update db cfg for mamgmdb using LOGPRIMARY 15

修改辅助日志文件个数:db2 update db cfg for mamgmdb using LOGSECOND 0

DB2 数据库一旦创建就无法再修改字符集的编码方式了。

可以在创建的时候指定字符集,如下指定为GBK:

create db SRCDB using codeset GBK territory CN

设置在锁上等待的时间

db2 "update db cfg for DBNAME using LOCKTIMEOUT 15"

主机上所有实例(其实就是用户)

db2ilist

显示的是当前实例下catalog的DB信息

db2 list db directory

查看catalog中远程节点node的信息(实际就是远程数据库的信息)

db2 list node directory

查看表空间信息

db2 list tablespaces show detail

查看DB2 instance是启动还是停止的

1、db2_ps

2、db2pd -inst

3、ps -ef | grep -i "db2sysc" | grep -i "<instance name>"

4、db2gcf -s

通过端口来查看哪个用户建了这个数据库

vi /etc/services

该文件里面有用户以及对应的端口,如:

DB2_ma_onldb 60032/tcp

DB2_ma_onldb_1 60033/tcp

DB2_ma_onldb_2 60034/tcp

财税库银实现类查询

select a.*,b.tran_name,b.tran_type,b.tran_class from t_sub_tran a ,t_tran b where a.tran_code=b.tran_code;

预置刷新共享内存表tbl_mamgm_para_task_syncshm_status和预置同步子系统表tbl_mamgm_para_task_syncsys_status

在公参同步中,一个1000条的批次,会插入2条(联机+批量)记录。

创建参数新增任务、创建参数修改任务,创建参数删除任务

这些动作之前要校验是否可以操作:

ParameterFlexFacade.checkParaOperatable()

其中checkParaRecordSyncIn函数调用了para_tbl_attr表的sync_in_exp字段,该字段是一个表达式,其中替换以后可以验证,如果验证失败将会抛exception,比如:

throw new BizException("主表正式表记录不存在,不允许操作!");

throw new BizException("此记录是只读的,不允许修改和删除操作!");

过滤条件组信息表,修改时报:“此记录是只读的,不允许修改和删除操作!”

原因是:tbl_mamgm_para_tbl_attr中该记录的字段SYNC_IN_EXP配置了下面语句:只有6开头的过滤条件组id才可以修改。

boolean result = !"#{RULE_GRP_ID}".startsWith("6");

01030201TBL_MAMGM_FILTER_RULE_GRP_INF过滤条件组信息表

报错的地方在:ParameterFlexFacade。checkParaRecordSyncIn函数

maps_sys是表示该记录是技术参数,不能操作

这个限制是指:para_tbl_attr表中sync_in_exp字段配置的:

boolean result = "maps_sys".equalsIgnoreCase("#{REC_UPD_USR_ID}");

目前多渠道包括两张表有此限制:

TBL_MAPS_GFS_MSG_SPEC_INF报文规范类型信息表,TBL_MAMGM_ACCESS_SYS接入系统标识表

sync_in_exp字段配置的其它包括:

TBL_MAMGM_FILTER_RULE_GRP_INF过滤条件组信息表boolean result = !"#{RULE_GRP_ID}".startsWith("6"); 不以6开头的的,就

TBL_MAMGM_FILTER_APP_INF过滤应用信息表boolean result = !"#{APP_ID}".startsWith("9");

批量的两张表任务表:

TBL_MABAT_BAT_TASK_CTRL

TBL_MABAT_RECNCL_TASK_INF

订单页面宽度变小后,多出一条横杆,解决办法:

1、main.css

.table_head 中去掉

background:url(../images/table_top_back.jpg) left top repeat-x;

这样换行就不会有一条杠了

2、WebContent/com/cup/isvr/portal/jpf/orderview/index.jsp中<th>与汉字之间加上

<div nowrap="nowrap">

</div>

3、把.datashow th行的line-height:27px;删除

HTTP GET和POST的区别

1、都是明文传输,都是不安全的

2、GET是在url上追加参数,POST在浏览器的地址栏中看不见参数,它是将表单内各个字段与其内容放置在HTML HEADER内

3、POST不会被浏览器缓存

4、GET是获取指定URL上的资源,是读操作,不论对某个资源GET多少次,它的状态是不会改变的

POST的语意是对指定资源“追加/添加”数据

5、长度限制,GET不能大于2k,POST一般认为不受大小限制。

浏览器中get方式:request.getContentLength()=-1,http规范中没有限制get方式不可以设置cotent-length,

GET /mjc/webtrans/PBRG HTTP/1.1

HOST: 172.17.248.74:11000

Accept: */*

Content-Length: 3

q=a

webservice的war包中wsdl和xsd文件既可以放在\WEB-INF\src\com\cup目录下,

也可以放在\WEB-INF\classes\com\cup在,用ant脚本编译workshop建的webservice工程时要修改web.xml文件

<2011-12-2 下午02时21分49秒 CST> <Warning> <Socket> <BEA-000402>

<There are: 5 active sockets, but the maximum number of socket reader threads allowed by the configuration is: 4.

You may want to alter your configuration.>

解决:左边菜单servers -> configuration -> tuning下,将Socket Readers:由33改成99

注:上面一行勾上Enable Native IO可显著提供weblogic性能

使用ant打包时,如果仅仅是import一个类,不在程序中使用该类的任何方法,或者new该类

就算这个类不在classpath中,也不会报错,且生成的class文件中没有import那句话。

W.java文件内容:

class W{

static{

System.out.println(org.apache.commons.net.ntp.TimeStamp.getCurrentTime());

}public static void main(String[] args){

}}

在cmd中执行情况是:成功、成功、成功、失败。

javac -cp "d:\bea\modules\com.bea.core.apache.commons.net_1.0.0.0_1-4-1.jar" W.java

java -cp ".;d:\bea\modules\com.bea.core.apache.commons.net_1.0.0.0_1-4-1.jar" W

javac -cp "D:\bea\wlserver_10.3\server\lib\weblogic.jar" W.java

java -cp "D:\bea\wlserver_10.3\server\lib\weblogic.jar" W

1、很明显weblogic.jar中没有org.apache.commons.net.ntp.TimeStamp类,为什么能编译通过

2、把weblogic.jar拷贝到比如D:\bea\wlserver_10.3\server目录下,就编译不过了。为什么?

对于db2中字段是char型的后面补了空格的情况,在java中用sql查出来时也是带空格的。

要在sql中或者resultset结果中使用trim()去掉空格。

启动多渠道管理应用时,执行分别会执行下面脚本

mapsDomain/startWL.sh

mapsDomain/startWebLogic.sh

mapsDomain/bin/startWebLogic.sh 配置DOMAIN_HOME、JAVA_OPTIONS

${DOMAIN_HOME}/bin/setDomainEnv.sh 配置WL_HOME、JAVA_VM、JAVA_HOME、USER_MEM_ARGS、PRODUCTION_MODE、DOMAIN_PRODUCTION_MODE、SERVER_NAME、JAVA_OPTIONS

${WL_HOME}/common/bin/commEnv.sh 配置BEA_HOME、WL_HOME、JAVA_HOME、JAVA_VENDOR、WEBLOGIC_CLASSPATH、PATCH_CLASSPATH、CLASSPATHSEP

现在想要做一个java的socket客户端,C的socket服务端。客户端向服务端发送的报文中头四个字节是整型,表示报文总长度,

之后才是报文内容。在C里很好做,先把长度转成网络字节序,再拷贝到四个字节的缓冲区里。但是JAVA中要怎么做呢?

答:使用DataOutputStream,用其中的writeInt方法

此方法是如下操作:>>>表示无符号右移,左移没有无符号一说,即没有<<<

out.write((v >>> 24) & 0xFF);

out.write((v >>> 16) & 0xFF);

out.write((v >>> 8) & 0xFF);

out.write((v >>> 0) & 0xFF);

int v =-2;

int s = v >> 1;

System.out.println(s);//-1

s = v >>> 1;

System.out.println(s);//2147483647

//00000000 00000000 00000000 00000000表示0

//01111111 11111111 11111111 11111111表示2147483647

//10000000 00000000 00000000 00000000表示-2147483648

//10000000 00000000 00000000 00000001表示-2147483647

//11111111 11111111 11111111 11111111表示-1 //通过System.out.println(Integer.toBinaryString(-1));方法可以看到二进制码

* Java 和一些windows编程语言如c、c++、delphi所写的网络程序进行通讯时,需要进行相应的转换

* 高、低字节之间的转换

* windows的字节序为低字节开头

* linux,unix的字节序为高字节开头

* java则无论平台变化,都是高字节开头

使用weblogic的jta全局事务

ctx = getInitialContext();//创建一个上下文环境

javax.transaction.UserTransaction ut = (javax.transaction.UserTransaction)ctx.lookup("javax.transaction.UserTransaction");

ut.begin();

...

ut.commit();

transient

java语言的关键字,变量修饰符,如果用transient声明一个实例变量,当对象存储时,它的值不需要维持。

Java的serialization提供了一种持久化对象实例的机制。当持久化对象时,可能有一个特殊的对象数据成员,

我们不想用serialization机制来保存它。为了在一个特定对象的一个域上关闭serialization,可以在这个域前加上关键字transient。

当一个对象被串行化的时候,transient型变量的值不包括在串行化的表示中,然而非transient型的变量是被包括进去的。

如果不implements Cloneable的话,那么调用super.clone()函数将抛出CloneNotSupportedException异常

shell脚本中获得日期

CURTIME=`date +%Y%m%d%H%M%S`

echo $CURTIME

JAVA四个方位修饰符

private--类内部

default--类内部,同包无继承关系类,同包子类

protected--类内部,同包无继承关系类,同包子类,不同包子类

public-类内部,同包无继承关系类,同包子类,不同包子类,不同包无继承关系类

@SuppressWarnings("serial")在Java中有什么作用?

@SuppressWarnings可以抑制一些能通过编译但是存在有可能运行异常的代码会发出警告,你确定代码运行时不会出现警告提示的情况下,可以使用这个注释。

("serial") 是序列化警告,当实现了序列化接口的类上缺少serialVersionUID属性的定义时,会出现黄色警告。可以使用@SuppressWarnings将警告关闭

表清理问题

TBL_MAMGM_TABLE_CLEAN_CFG

clean_md:0-多表清理;1-清理无效数据;2-清理指定表

ma_batdb.tbl_mabat_trans_log_chk_fail勾兑差错流水表,属于2-清理指定表;共7张,清理星期几的那张表的数据

ma_onldb.tbl_maonl_trans_refund退货表,也属于2-清理指定表,共3张,每月3号清理 第(month % 3 + 1)张表。

像众多的“0-多表清理”方式的表,表号取自ma_gfsdb.TBL_MAPS_GFS_DYN_SYS_PARA

ma_batdb.tbl_mabat_elct_prod_infBAT电子产品表,属于1-清理无效数据

ma_batdb.tbl_mabat_trust_data_infBAT托管数据表,属于1-清理无效数据

批量应用绑管理库

执行/maps/usr/hg_bat1/glb/gfs/sbin/mgmbind.sh

联机批量报818错,bind管理库有问题,需要将glb/gfs/bin/MDatasync_bat进程和glb/gfs/bnd/MDatasync_mgmdb.bnd文件一同拷贝

,注意进程的可执行chmod

taskcom list

进程扫描管理库的TBL_MAPS_GFS_TASK表,共享内存里面去

HttpServlet为什么要实现serializable?

我认为主要的原因是servlet容器可能会钝化servlet,把不活跃的servlet暂时持久化到IO设备

The servlet engine is not required to keep a servlet loaded for any period of time or

for the life of the server. Servlet engines are free to use servlets or retire them at any

time. Therefore, you should not rely on class or instance members to store state

information.

When the servlet engine determines that a servlet should be destroyed (for example,

if the engine is shut down or needs to conserve resources), the engine must allow the

servlet to release any resources it is using and save persistent state. To do this, the

engine calls the servlet’s destroy method.

The servlet engine must allow any calls to the service method either to complete

or to end with a time out (as the engine defines a time out) before the engine can

destroy the servlet. Once the engine destroys a servlet, the engine cannot route any

more requests to the servlet. The engine must release the servlet and make it eligible

for garbage collection.

容器不要求每个servlet都一直维持在内存,可以钝化,servlet也支持多种类加载方式,包括反序列化。

下拉框的两表DRDL_CFG和DRDL_ITEM_DEF都不支持oper_in in ('d','D')的过滤

DRDL_CFG表:DropDownCache.queryAll()

DRDL_ITEM_DEF表:

DataDropDown.java的构造函数调用了DropDownBaseImpl的构造函数,再调用了DataDropDown的init(),sql=SQL_LBLCD+...

SQL_LBLCD是在DropDownBaseImpl中定义:

static final String SQL_LBLCD="SELECT A.drdl_item_key,A.drdl_item_val FROM TBL_MAMGM_DRDL_ITEM_DEF A,"

+"TBL_MAMGM_DRDL_CFG B WHERE A.drdl_id=B.drdl_id AND B.drdl_nm=";

查看系统使用表空间的方法:

1、连接到目标数据库

命令:db2 connect to mamgmdb user username using password(username和password需要替换为正确的值)

2、查看数据库表空间使用情况

命令:db2 list tablespaces show detail

查看表空间所属容器信息

db2 list tablespace containers for 1 show detail

3、判断数据库表空间使用率是否正常的方法:

首先判断表空间类型(Type),如果Type= System managed space,说明表空间是操作系统管理的表空间,表空间自增长,只需关注表空间所在的文件系统的利用率。

如果Type= Database managed space,说明表空间是数据库管理的表空间,表空间非自增长,需要关注Used pages与Useable pages的比值,当(Used pages/Useable pages)>80%,需要及时向系统室值班岗报告。

查看数据库是否使用了归档日志,OFF为循环日志

db2 get db cfg for gmabatdb|grep LOGRETAIN

Log retain for recovery enabled (LOGRETAIN) = OFF

Log retain for recovery enabled (LOGRETAIN) = RECOVERY (为归档日志)

AIX主机名:

hostname

主机名对应的IP

vi /etc/hosts

aix查看某进程打开的文件数量

procfiles -n pid

对某进程强制垃圾收集

procfiles -F pid

UdpServlet的启动日志在cup_maps_alarm.log里面

多渠道和行综也会被xss跨站脚本攻击,原因就是这次新加的titleNm值

https://172.17.248.188:7002/isvr/com/cup/isvr/portal/jpf/flex/parameter.jsp?subjectId=010911&titleNm=ddd");}alert('xss');>

https://172.17.248.188:7002/isvr/com/cup/isvr/portal/jpf/flex/parameter.jsp?subjectId=010911&titleNm=ddd");}alert(request.getParameter('subjectId'));>

Apache JMeter是Apache组织开发的基于Java的压力测试工具。用于对软件做压力测试

SQL

对于查不出结果的sql语句的ResultSet一点不同:

select * from tbl_mamgm_para_task where EVENT_ID =2rs.next() == false

select 1 from tbl_mamgm_para_task where EVENT_ID =2rs.next() == false

select sum(1) from tbl_mamgm_para_task where EVENT_ID =2rs.next() == true,且rs.getInt(1)==0

flex的DateField日期组件,默认是不可修改。如果需要修改增加属性:

editable="true"

weblogic热部署必须要把启动模式改成开发模式,方法是config.xml中标签<production-mode-enabled>改成false。

热部署的build.xml关键语句

<target name="redeploy" description="redeploy ear to WebLogic on ${wls.ip}:${wls.port};">

<wldeploy user="${user}" password="${password}" adminurl="t3://${wls.ip}:${wls.port}" debug="true" remote="true" upl

oad="true" action="redeploy" name="${map.earApp.name}" source="${dest.home}/dest/${map.earApp.name}.ear" verbose="true" />

</target>

在TimerTaskStartThread类中增加了catch NoSuchEJBException{break;}的原因是:

答:在redeploy管理应用ear包的时候,增加了一个TimerTaskStartThread线程,但是原先的TimerTaskStartThread线程仍在,

只是原先线程缓存了之前的ejb对象,导致了一直报错,虽然新的TimerTaskStartThread线程使得功能无影响,

但是break出去以后就不会在nohup.out里面报错了。

当db2中某表被锁,当使用weblogic数据源select该表,或者java应用通过jdbc select该表,均在10秒钟后报错,一个的errorcode=-4470,

另一个的SQLCODE=-911,这个超时时间10秒设置在:

1、db2 "update db cfg for DBNAME using LOCKTIMEOUT 15" 此处15是指设置锁上等待15秒

2、重启db2实例,才能生效

AIX查看某个端口被哪个进程占用

1. netstat -Aan|grep <portnumber>

2. 如果是 tcp 连接,则 rmsock <PCB/ADDR> tcpcb,如果是 udp 连接,则 rmsock <PCB/ADDR> inpcb

下面我们以 telnet 服务所使用的 23 号端口为例,说明该方法:

#netstat -Aan|grep 23

f1000200019ce398 tcp 0 0 *.23 *.* LISTEN

可以看到 PCB/ADDR 为 f1000200019ce398 ,且协议类型为 tcp

#rmsock f1000200019ce398 tcpcb

The socket 0x19ce008 is being held by proccess 185006 (inetd).

命令报告该端口正在被 inetd 进程使用, PID 为 185006 。

3. ps -ef |grep PID

windows查看端口占用命令

1、netstat -aon|findstr "80"

2、tasklist|findstr "2448"

windows杀死进程命令

tskill PID或者

HttpServletResponse的getBufferSize()方法获取Web容器的以kb为单位的目前缓冲区大小

cvs上被remove和commit的文件,恢复的办法:

答:根据版本号或者标签号checkout下来,例如historyFrame.html文件已经被彻底删除:

cvs co -r maps-7760-20120724 maps_mgm/flex/comm/html-template/history/historyFrame.html

日切日期:

同步模块会校验:管理发给的日期 = TBL_MAPS_GFS_DYN_SYS_PARA.MAPS_SETT_DATE + 1 校验不过直接报错

这个字段表示当前使用哪张表:

TBL_MAPS_GFS_DYN_SYS_PARA.multi_tab_act

第一位:0表示不在日切窗口期,1表示在日切窗口

第二位:2套表使用第几张

第三位:3套表使用第几张

第四位:7套表使用第几张

应用启动时数据源连接池的驱动用的是mapsDomain/lib/db2jcc.jar,

启动时,weblogic会自动去mapsDomain/lib下加载所有jar包。

FAQ

Some solutions to common problems:

Exception

java.lang.IllegalStateException: Application was not properly initialized at startup, could not find Factory: javax.faces.context.FacesContextFactory

Solution

Include a listener in your web.xml:

<listener>

<listener-class>com.sun.faces.config.ConfigureListener</listener-class>

</listener>

问题:jsf的javax.faces.application.ViewExpiredException异常

答:去掉richfaces4的jar包

数据库字段,前面加上函数就不走索引了

select * from TBL_MAMGM_POS_PARA_INF WHERE LOWER(mchnt_cd) LIKE '11%';

RETURN0.0 %13993.33593751.350166272E913474.07.85886144638061513993.32128906251.35012864E913474.00.00.013474.00.00.0

MA_MGMDB.TBL_MAMGM_POS_PARA_INF TBSCAN100.0 %13993.33593751.350166272E913474.07.85886144638061513993.32128906251.35012864E913474.00.00.013474.00.00.044675.437512

weblogic上ssl的端口默认是7002,所以有可能7002不出现在config.xml文件中

eclipse默认启动内存在eclipse.ini文件中配置:

诸如:

-Xms128m

-Xmx512m

-Duser.language=en

-XX:PermSize=128M

-XX:MaxPermSize=256M

boolean offer(E e)

Inserts the specified element into this queue if it is possible to do so immediately without violating capacity restrictions. When using a capacity-restricted queue, this method is generally preferable to add(E), which can fail to insert an element only by throwing an exception.

它们的区别就是add 方法在插入失败的时候会抛出 IllegalStateException 异常

而offer可以通过返回值来判断成功与否

Server监听

Socket clientSocket = serverSocket.accept();

tcp 0 0 *.8886 *.* LISTEN

已建立的链接

cp4 0 0 172.17.248.74.8886 172.17.236.133.3966 ESTABLISHED

java做webservice时获得客户端的信息

import javax.servlet.http.HttpServletRequest;

import javax.xml.ws.WebServiceContext;

import javax.xml.ws.handler.MessageContext;

@Resource

WebServiceContext messageContext;

MessageContext mc = messageContext.getMessageContext();

HttpServletRequest request = (HttpServletRequest)mc.get(MessageContext.SERVLET_REQUEST);

String remortAddress = request.getRemoteAddr();

/*request.getLocale()=zh_CN

request.getLocalAddr()=172.17.248.74

request.getLocalName()=host01

request.getLocalPort()=8888

remortAddress=172.17.236.133

request.getRemoteHost()=172.17.236.133

request.getRemotePort()=3823

request.getRemoteUser()=null*/

System.out.println("request.getLocale()="+request.getLocale());

System.out.println("request.getLocalAddr()="+request.getLocalAddr());

System.out.println("request.getLocalName()="+request.getLocalName());

System.out.println("request.getLocalPort()="+request.getLocalPort());

System.out.println("remortAddress="+remortAddress);

System.out.println("request.getRemoteHost()="+request.getRemoteHost());

System.out.println("request.getRemotePort()="+request.getRemotePort());

System.out.println("request.getRemoteUser()="+request.getRemoteUser());

j2se开启webservice服务:

String wsUrl= "http://172.17.236.133:8888/MtqWebService?wsdl";

Endpoint.publish(wsUrl, new MtqWebService());

MtqWebService是一个类,需要标注@WebService、@WebMethod。

如果想让webservice服务的方法抛出异常必须要把异常包装成SOAPException,如:

@WebMethod

public String callByXml(String xmlData) throws Exception{

throw new SOAPException("dqqqqq");

}

Exception in thread "main" javax.xml.ws.WebServiceException: org.apache.cxf.service.factory.ServiceConstructionException

at org.apache.cxf.jaxws.EndpointImpl.doPublish(EndpointImpl.java:331)

at org.apache.cxf.jaxws.EndpointImpl.publish(EndpointImpl.java:234)

at org.apache.cxf.jaxws.spi.ProviderImpl.createAndPublishEndpoint(ProviderImpl.java:112)

at javax.xml.ws.Endpoint.publish(Endpoint.java:170)

at com.sl.ws.threadpool.MtqWebAction.main(MtqWebAction.java:22)

解决:去掉jbosslib的user library

Caused by: java.security.PrivilegedActionException: com.sun.xml.internal.bind.v2.runtime.IllegalAnnotationsException: 2 counts of IllegalAnnotationExceptions

Class has two properties of the same name "msg"

this problem is related to the following location:

at public java.lang.String com.sl.ws.model.Request.getMsg()

at com.sl.ws.model.Request

this problem is related to the following location:

at public java.lang.String com.sl.ws.model.Request.msg

at com.sl.ws.model.Request

Class has two properties of the same name "msgRes"

this problem is related to the following location:

at public java.lang.String com.sl.ws.model.Response.getMsgRes()

at com.sl.ws.model.Response

this problem is related to the following location:

at public java.lang.String com.sl.ws.model.Response.msgRes

at com.sl.ws.model.Response

解决:将com.sl.ws.model.Request和 com.sl.ws.model.Response类中的属性从public改成private

weblogic在console中做update、stop、delete应用时,会调用Servlet的destroy()方法。

对于某些类的静态static实例变量,要在destroy方法中做clear,否则执行update、stop、delete后,static实例变量被认为是null值。

原先的static实例变量所指的对象将永远存在,直到domain被stoped

java socket的连接超时时间:

Socket socket = new Socket();

socket.connect( new InetSocketAddress( "172.17.236.133", 4700 ),5000); //比如此处设置成5s

如果端口4700在server上没有监听:

1、如果该client与server的ip在同一网关内,java较容易找到该server机器,则直接抛错:java.net.ConnectException: 远程主机拒绝 connect 操作尝试。

2、如果该client与server的ip不在同一网关内,java将会去DNS上找路由,时间较长,那么超时抛错会出现:java.net.SocketTimeoutException: connect timed out

由于AIX(或UNIX)系统和Windows系统对于文本文件的行末结束符(或回车换行符)的处理方式不同,

当我们将Windows格式的一个文本文件以BIN格式(而不是ASCII方式)上传至AIX上时,用vi查看该文件会发现每行的行末出现一个^M的符号。

这会导致AIX系统下对该文本文件的处理出现异常,并且在该文件是脚本的情况下,也会导致脚本执行异常。

杀死本用户下的weblogic进程

ps -fu $USER |grep weblogic|grep -v grep|awk '{print $2}'|xargs kill -9 $1

乱码

public static String getEncodedString(Object p) {

boolean isDefaultChinese = Locale.getDefault().getLanguage()

.toLowerCase().indexOf("zh") != -1;

String tmpStr = p.toString();

if (!isDefaultChinese)

try {

tmpStr = new String(tmpStr.getBytes("GBK"), "ISO8859_1");

} catch (UnsupportedEncodingException e) {

e.printStackTrace();

}

return tmpStr;

}

网络传输中有个二进制0的概念,一个字节8位全是二进制0,在java里面表示byte b = '\0',

对于new String(byte[])以后,二进制0还会存在,只要做了trim()就去掉了。

如果把二进制0赋予整型会变化成ascii的0.

int i = '\0';

System.out.println("i="+i);//i=0

weblogic的web应用:

提交了重新编译的class文件,哪怕是其中一个文件,或者不相干的class文件,

原先class中static变量的值都被赋null了。

JDK5.0 java.util.concurrent包中引入对Map线程安全的实现ConcurrentHashMap

java.util.concurrent包也提供了一个线程安全的ArrayList替代者CopyOnWriteArrayList

如何讲二进制流 加入XML报文中发送?

// 将 s 进行 BASE64 编码

public static String getBASE64(String s) {

if (s == null) return null;

return (new sun.misc.BASE64Encoder()).encode( s.getBytes() );

}

// 将 BASE64 编码的字符串 s 进行解码

public static String getFromBASE64(String s) {

if (s == null) return null;

BASE64Decoder decoder = new BASE64Decoder();

try {

byte[] b = decoder.decodeBuffer(s);

return new String(b);

} catch (Exception e) {

return null;

}

}

只要在xsd中,将某个字段类型设置成base64Binary,jaxb能自动讲xml中的BASE64 编码的字符串解析成正确的byte[]数组。

Socketsocket = new Socket();

//socket.setSoTimeout(5000);

InetSocketAddress local = new InetSocketAddress("172.17.246.1",0);

socket.bind(local);

socket.connect( new InetSocketAddress( "145.17.236.133", 4700 ),1000);

socket.setSendBufferSize(100);

mian2 aix测试结论:

1、新增一个new NioSocketConnector(1),增加4个句柄的使用。只开一个NioProcessor,即只用一个cpu,只开一个select.open()

2、新增一个new NioSocketConnector(),增加了4*(4+1)个句柄。第2个4:是248.74上有4核的cpu 4+1是默认值

3、做一次connector.connector()操作,即新增一条链路的话,增加1个句柄

4、new NioSocketConnector()和new NioSocketConnector(Runtime.getRuntime().availableProcessors() + 1)是一样的。

log4j.properties、CommPacket.ini、FilePacket.ini、mtq.properties 先找mtqCfg/ ,再找appCfg/,再找当前路径下

mtqNetwork.xml、mtqService.xml 必须在mtqCfg目录下,或者mtqCfg/sysname/目录下

如何使用JDK自带的JConsole监控Weblogic

http://172.17.249.10/NewSys/OA/KnowledgeBase/ShowKb.aspx?Id=6440&Key=

在java启动时添加:

-Dcom.sun.management.jmxremote.port=41125 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false

在windows path中:

Jconsole

myeclipse6.0

今天安装完eclipse和myeclipse以后,发现启动后窗口的标题栏显示:wtp java ee(myeclipse incompatible)?

选其它的perspective(视图): MyEclipse Java Enterprise

官方文档指出,WebLogic 9 / WebLogic 10 的线程池是自调优的,并且在WebLogic 9的时候,

通过修改config.xml可以修改默认线程池的最小值、最大值,但是很麻烦。

到了WebLogic 10gR3,连修改config.xml的办法都给取消了。

但是,可以通过在启动脚本增加如下参数,可以指定默认线程池的最小值、最大值:(http连接数)

-Dweblogic.threadpool.MinPoolSize=100 -Dweblogic.threadpool.MaxPoolSize=500

HashMap map.get(null) 返回null

ConcurrentHashMap concurmap.get(null) 报错java.lang.NullPointerException

ConcurrentHashMap concurmap.put(Integer.valueOf(2),null);报错java.lang.NullPointerException

Map遍历方式

for(Map.Entry<String, String> map : formFldValues.entrySet()){

queryString += map.getKey()+" like ? and";

values.add(map.getValue());

}

xml 转 javabean方式

//方式一 jaxb ,无需额外lib包

/*InputStream is = null; 效率最差

try {*/

// System.out.println(REQ.class.getPackage().getName());

/*JAXBContext jc = JAXBContext.newInstance(REQ.class.getPackage()

.getName());// 包名

Unmarshaller u = jc.createUnmarshaller();

is = new ByteArrayInputStream(xmlStr.getBytes("GBK"));

REQ req = (REQ) u.unmarshal(is);*/

//方式二 xsream ,需xstream-1.3.1.jar 10w次 78390ms

/*XStream xs1 = new XStream(new DomDriver());

xs1.alias("REQ", REQ.class);

REQ req = (REQ) xs1.fromXML(xmlStr);*/

//方式三 dom4j,需dom4j-1.6.1.jar 10W次 54203ms

Document doc=null;

try {

doc = DocumentHelper.parseText(xmlStr);

} catch (DocumentException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} // 将字符串转为XML

Element rootElt = doc.getRootElement(); // 获取根节点

System.out.println("根节点:" + rootElt.getName()); // 拿到根节点的名称

System.out.println(rootElt.elementTextTrim("SYSTEMNAME"));

//方式四 stax 10w次 6125ms

static XMLInputFactory inputFactory = XMLInputFactory.newInstance();

byte[] byteArray = xml.getBytes("GBK");

ByteArrayInputStream inputStream = new ByteArrayInputStream(byteArray);

XMLStreamReader reader = inputFactory.createXMLStreamReader(inputStream);

int event = reader.getEventType();//获取节点类型,结果是以整形的方式返回的。

while (reader.hasNext()) {

switch (event) {

case XMLStreamConstants.START_DOCUMENT://表示的是文档的开通节点。

break;

case XMLStreamConstants.START_ELEMENT://开始解析开始节点

if (reader.getLocalName().equals("SYSTEMNAME")) {//判断节点的名字

mr.setSystemName(reader.getElementText());

}

break;

}

event = reader.next();

}

//方式五 自解 10w次 1437ms

mr.setSystemName(sb.substring(sb.indexOf("<SYSTEMNAME>")+12,sb.indexOf("</SYSTEMNAME>")));

使用cxf测试了csb上webservice,证明可行:

但是csb似乎不支持使用一个url获取wsdl,原因是解析后的wsdl文件倒数第四行address location是主机名,而不是ip

如:

http://P570_F_3:7001/csb/shcenter/BillDomain/MultiAcquiringSystem/BpsServiceImplService/BpsServiceImplServiceProxy

所以需要把wsdl保存在d:/BpsServiceImplServiceProxy.wsdl,然后将上述address location替换如下:

http://172.17.252.63:7001/csb/shcenter/BillDomain/MultiAcquiringSystem/BpsServiceImplService/BpsServiceImplServiceProxy

其效果与使用应用自己的webservice一样。

http://172.17.252.85:4866/MapsServicePortal/BpsServiceImplService?wsdl

此外还可以把解析好的变量设置成final类型:

JaxWsDynamicClientFactory dcf = JaxWsDynamicClientFactory.newInstance();

final Client client = dcf.createClient("d:/BpsServiceImplServiceProxy.wsdl");

Object[] res = client.invoke("excuteBpsService","<CUPBPS></CUPBPS>","BPS", "MAPSQUERY");

System.out.println("Echo response: " + res[0]);

如果xml请求报文中无<FILECONTENT>标签,则进不去这个if中

} else if (reader.getLocalName().equals("FILECONTENT")) {//判断节点的名字

如果xml请求报文中有,且值为空,如<FILECONTENT></FILECONTENT>,则

String s = reader.getElementText();

System.out.println((s==null));//false

System.out.println((s.equals(""))); //true

byte[] b = s.getBytes();

System.out.println((b==null));//false

System.out.println((b.length));//0

log4j级别依次下降

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level OFF;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level FATAL;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level ERROR;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level WARN;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level INFO;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level DEBUG;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level TRACE;

// Field descriptor #56 Lorg/apache/log4j/Level;

public static final org.apache.log4j.Level ALL;

持卡人管理upjas配置文件

$HOME/upjas/upjas-minimal/server/default/cup-deploy/mtqCfg

domain启动时脚本,以及nohup.out文件位置

$HOME/upjas/upjas-minimal/bin

java使用udp

客户端:

DatagramPacket packet = new DatagramPacket(msg.getBytes(), Integer

.valueOf(msg.length()), address, Integer.valueOf(port));

DatagramSocket socket = new DatagramSocket();

socket.send(packet);

//发送以后socket记下了本机使用的临时端口:socket.getLocalPort()

//所以之后可以监听端口等待了

byte[] message = new byte[256];

DatagramPacket recpacket = new DatagramPacket(message, message.length);

socket.setSoTimeout(10 * 1000);

socket.receive(recpacket);

//从udp包中获取数据是这样的:

String recmsg = new String(recpacket.getData(),0,recpacket.getLength());

System.out.println("client:"+recmsg);

服务端:

DatagramSocket socket = new DatagramSocket(Integer.valueOf(port)); //监听一端口

byte rb[] = new byte[1024];//申请一块内存

DatagramPacket pac = new DatagramPacket(rb, rb.length);//装成udp包

socket.receive(pac);//阻塞读,一旦收到内容,往udp包里面写信息,如:客户端ip、port;真实数据写入内存rb中

//使用接收时用的udp包中的客户端ip和port,将信息返回到客户端

String message = "toclient";

DatagramPacket recpacket = new DatagramPacket(message.getBytes(),message.length(), pac.getAddress(), pac.getPort());

socket.send(recpacket);// 发送回去

//另一种方式,原路返回客户端

pac.setData(message.getBytes());

socket.send(pac);// 发送回去

实践证明如果主机网卡上有两个ip(逻辑ip),那么下面代码,未绑定一个ip时,udp服务将在两个ip的端口上监听,udp客户端可以往两个ip的这个端口发消息

DatagramSocket socket = new DatagramSocket(Integer.valueOf(port));

且可以绑定两个ip的一个端口2次,下面的两个ip在一块网卡上。

String ip = "172.17.236.134";

InetAddress serveraddress = InetAddress.getByName(ip);

DatagramSocket socket = new DatagramSocket(Integer.valueOf(port),serveraddress);

String ip = "172.17.236.133";

InetAddress serveraddress = InetAddress.getByName(ip);

DatagramSocket socket = new DatagramSocket(Integer.valueOf(port),serveraddress);

如果ip是null或者“”,那么返回值是127.0.0.1的地址,

InetAddress serveraddress = InetAddress.getByName(ip);

----> impl.loopbackAddress();

AIX5.3上如何查IP配置及子网掩码!

smitty tcpip选中你要看的网卡,回车.看完后按ESC+0退出就可以了.

查看网卡信息

lsdev -Cc adapter|grep ent

ifconfig -a 查出有几个网络接口,因为可能装有多个网卡。假设有ent0、ent1

lscfg -v -l ent0,就可以查到这块网卡的包括子网掩码、所在插槽位置等多个信息。

count(*)和order by一起会报错?

select count(*) from TBL_MAMGM_DRDL_CFG order by drdl_id;

从javaEE5开始,jpa规范脱离了EJB规范,好处是J2SE环境也可以使用jpa持久化层了。

eclipse生成javadoc

Project -> Genetate JavaDoc

如果项目编码不是GBK而是UTF-8,那么在Extra javadoc options写上:

-encoding UTF-8

-charset UTF-8

ApplicationInfoUtil的属性是无法通过管理页面刷新获得更新的,要改?

为什么API里FileReference有load()方法和data属性却不能使用?

FileReference的load()方法和data属性需要使用flashplayer 10的版本,

要添加playerglobal.swc,在你所用的sdk包下面,我这里的路径是sdk3.5.0.12683/frameworks/libs/player/10/playglobal.swc

flex builder3 默认要求flash player 最低要9,需要改成10.0,修改方法如下:

右键点击项目,在项目属性中找 flex compile, 修改 html wrapper,把9.0.24改为10.0.0

flex工程ParaCommon报如下错误:'isNaN' is marked as extern, but '__AS3__.vec:Vector$int' is not?

右键工程-》Flex Library Compiler -》 Additional compiler arguments ->-target-player=10

so I went back to my application project to see if I had any special compiler settings, and remembered I had :

-target-player=10

Facade类的方法抛出BizExcpetion前台也获取不了。

@Column放在setPageImport上竟然获取不了数据库的值,只有放在getPageImport才正确。

flash10开始,FileReference增加了一个save方法,参数为(data:Object, defaultFileName:String = null),在调用save方法时,只需将文件内容传给data,

浏览器会自动打开一个保存对话框,让用户选择保存目录。有两个要注意的地方,1、save方法flash10及以上才有,客户端flash版本需跟上,

且代码编译环境也要在10以上,eclipse环境下,选中项目,右键properties,flex compiler选项,将required flash player version 设为10.0.0或以上,

否则将找不到save方法。2、save方法只能通过用户交互来调用。怎么理解用户交互,例如,点击一个下载按钮这算是用户交互,

而一般的回调方法则不是用户交互。如下载一张图片,如果图片还没加载进来,我们经常是先要进行加载,然后监听事件,然后在回调函数里进行处理,

如果将save方法写在回调函数里面,将会报错:Error #2176: 某些动作(如显示弹出窗口的动作)只能通过用户交互来调用。

所以很多时候我们必须采用双按钮,一个用来加载数据,一个用来下载数据。

点“模版文件下载”按钮没反应:

解决:eclipse环境下,选中项目,右键properties,flex compiler选项,将required flash player version 设为10.0.0或以上,

treemap是自然顺序(默认自然顺序,是指如果key是int型就是按数字大小,如果key是string则按照字母顺序排列,如果实现了Comparator接口即可按照想要的顺序了),

linkedmap是插入顺序,ListOrderedMap,LRUMap等都是有一定规则的顺序的map...

PrepardStatement语句中占位符?不能在select的字段中,只能在where条件后?

持续insert时候,db2报如下错误:ERRORCODE=-805,SQLSTATE=51002

问题的根本是因为程序里有很多游标没有关闭

问题解决了,谢谢你的提醒!!

pstmt.executeUpdate();

pstmt.close();//加上这一行

就可以了。

新增菜单无法通过刷新管理缓存立刻可见?

原因:tbl_mamgm_access_inf表中的access_cd字段值最后多了一个空格

同步子系统失败了以后竟然到了同步成功这一状态???

flex3中datagrid组件中某个单元格可编辑时,如何在键盘输入值之后触发事件函数获得值?

有两个事件可以itemEditEnd、itemFocusOut。

<mx:DataGrid id="defindInfoGrid" editable="true" itemEditEnd="valueVaildate(event)"/>

public function valueVaildate(event : DataGridEvent) : void

{

//第几列

Logger.info("event.columnIndex1 :"+event.columnIndex);

//dataField值

var dataField:String = event.currentTarget.columns[event.columnIndex].dataField;;

Logger.info("dataField :"+dataField);

//编辑前值

var oldValue:String=event.itemRenderer.data[dataField];//对已知的dataField:event.itemRenderer.data.FIELD_DESC

Logger.info("oldValue :"+oldValue);

var cols:DataGridColumn=defindInfoGrid.columns[event.columnIndex];

//编辑后新的值

var newValue:String=defindInfoGrid.itemEditorInstance[cols.editorDataField];

Logger.info("newValue :"+newValue);

}

db2查询sql时报如下错

09:06:16 [SELECT - 0 row(s), 0.000 secs]

[Error Code: -968, SQL State: 57011] DB2 SQL error: SQLCODE: -968, SQLSTATE: 57011, SQLERRMC: null

增加你的system temp tablespace所在文件系统大小,或者database temp tablespace空间利用率

在weblogic中,如果有多个war、war包应用,默认的部署顺序都是100,改变方法是修改config.xml中的<deployment-order>98</deployment-order>项

<app-deployment>

<name>mjc</name>

<target>MapsServer</target>

<module-type>war</module-type>

<source-path>/GGZF/usr/mapsweb/shenlei/dest/mjc.war</source-path>

<deployment-order>98</deployment-order>

<security-dd-model>DDOnly</security-dd-model>

</app-deployment>

或者在console中,点deployment中的某一项应用。

页面新增参数,点保存时报“当前用户没有此操作权限!”

原因:TBL_MAMGM_PARA_SUB_AREA_INF表中的ACCESS_CD没写对

参数维护时,创建新增任务,点保存,报“用户没有权限”错误

原因:subject表上access_url填写错误。

使用ThreadLocal以空间换时间解决SimpleDateFormat线程安全问题,同时提高了每次new SimpleDateFormat的效率

class DateUtil2 {

private static final String DATE_FORMAT = "yyyy-MM-dd";

private static ThreadLocal<DateFormat> threadLocal = new ThreadLocal<DateFormat>() {

protected synchronized DateFormat initialValue() {

System.out.println("initial");

return new SimpleDateFormat(DATE_FORMAT);

}

};

public static DateFormat getDateFormat() {

return threadLocal.get();

}

public static String format(Date date) throws ParseException {

return getDateFormat().format(date);

}

public static Date parse(String textDate) throws ParseException {

return getDateFormat().parse(textDate);

}

}

PreparedStatement中进行模糊查询:

String = "select * from tbl_mamgm_comm_line_cfg where line_no like ?"

PreparedStatement ps = conn.prepareStatement(sql);

ps.setObject(1, "%000HCSN0001A1%");

ResultSet rs = ps.executeQuery();

java.util.zip

GZIPOutputStream类用于压缩

GZIPInputStream类用于解压缩

2012 年餐饮业收入23,283 亿元,同比增长13.6%。其中限额以上餐饮业收入7,799 亿元,同比增长12.9%

限额以上餐饮业是指年主营业务收入200 万元及以上的餐饮业企业 (单位)

sleep三秒

TimeUnit.SECONDS.sleep(3);

poi中设置单元格为文本格式:

HSSFCellStyle cellStyle2 = demoWorkBook.createCellStyle();

HSSFDataFormat format = demoWorkBook.createDataFormat();

cellStyle2.setDataFormat(format.getFormat("@"));

cell.setCellStyle(cellStyle2);

excel 2003 工作表最大有2^16=65536行,2^8=256列

excel 2007 和excel 2010最大有2^20=1048576行,2^14=16384列

ibm jdk gc(xml格式) 查看工具ga441.jar

Used Tenured(After) gc过后老年代使用的内存大小

Free Tenured(After) gc过后年老代未使用内存大小

Total Tenured(After) gc过后老年代总大小

Free Tenured(Before) gc之前年老代未使用内存大小

Total Tenured(Before) gc之前老年代总大小

Free Nursery(After) gc之后年轻代未使用内存大小

Total Nursery(After) gc之后年轻代总大小

Free Nursery(Before) gc之前年轻代未使用内存大小

Total Nursery(Before) gc之前年轻代总大小

分配失败(AF)导致的垃圾收集的verbosegc输出

compact压缩

如果未设置虚拟机参数-Xnocompactgc并且以下几个条件任何一个为true,那么就会发生堆压缩动作:

· 设置了虚拟机参数-Xcompactgc

· 清理阶段结束之后,还是无法满足分配需求

· 调用System.gc()并且在最后一次分配失败发生或者并发标识收集之前发生了压缩动作

· TLH消耗了至少一半的存储,并且TLH的平均大小低于1000字节

· 堆的空闲空间小于5%

· 堆的空闲空间小于128KB

其实IBM的gc的停止比我们想象中要短的多。STW(stop total world)只有在下面这些条件才执行:

1.到达heap limited或者allocation fail

2.System.gc方法被调用

3.Concurrent mark 完成所有的工作

调大nursery尺寸会导致垃圾回收的停顿时间加长。

对于1GB的堆,如果进行了压缩动作,垃圾收集的暂停时间可能增加到40秒。

增量压缩技术就是将压缩动作分散到多次垃圾收集周期中,以减少暂停时间。

-Xpartialcompactgc,表示每次垃圾收集都使用增量压缩,除非必须进行完整的压缩动作

使用ibm的HeapAnalyzer查看aix的dump文件(jdk有个工具:jmap -dump:live,format=b,file=d:\java.dump pid),内存映射--------ha445.jar

heapdump.20130605.160859.24969368.0004.phd

使用ibm的Thread and Monitor Dump Analyzer for java查看aix的core文件(通过kill -3 pid获得),查看线程、内存等完整信息--------jca432.jar

javacore.20130604.171533.10027244.0011.txt

java -Xmx1000m -jar jca432.jar

jmap 的用途是为了展示java进程的内存映射信息,或者堆内存详情

使用命令:

jmap pid 打印内存使用的摘要信息

jmap -histo:live pid 展示class的内存情况,展示的信息为编号,实例数,字节,类名

jmap -heap pid 展示pid的整体堆信息

jmap -dump:live,format=b,file=d:\java.dump pid导出的文件可以供分析用,比如jhat或者mat、ha445.jar,以便查找内存溢出原因

Jstat是Sun JDK中自带的监控工具,利用了JVM内建的指令对Java应用程序的资源和性能进行实时的命令行的监控,包括了对Heap size和垃圾回收状况的监控等等

jstat -gcutil 7432 5000 10每隔5000ms采样一次,一共采样10次

C:\Documents and Settings\沈雷>jstat -gcutil 7432 5000 10

S0 S1 E O P YGC YGCT FGC FGCT GCT

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

0.00 0.00 0.00 1.41 3.13 0 0.000 3 0.887 0.887

S0:年轻代中第一个survivor(幸存区)已使用的占当前容量百分比

S1:年轻代中第二个survivor(幸存区)已使用的占当前容量百分比

E:年轻代中Eden(伊甸园)已使用的占当前容量百分比

O:old代已使用的占当前容量百分比

P:perm代已使用的占当前容量百分比

YGC:从应用程序启动到采样时年轻代中gc次数

YGCT:从应用程序启动到采样时年轻代中gc所用时间(s)

FGC:从应用程序启动到采样时old代(全gc)gc次数

FGCT:从应用程序启动到采样时old代(全gc)gc所用时间(s)

GCT:从应用程序启动到采样时gc用的总时间(s)

如果FGC 过多,有必要调整下jvm参数。

F5负载均衡器简单的理解就是咱们通常称之四层交换机或七层交换机。同时也叫IP应用交换机

下载文件的按钮连点两次,页面上只会提示一个文件下载框,是第二次点击生成的文件

下载文件的文件保存框是resposne全部write完,还是开始写的时候就弹出来? 开始写

weblogic支持的最大http请求设置?

无法修改,可以通过在启动脚本增加如下参数,可以指定默认线程池的最小值、最大值:(http连接数)

-Dweblogic.threadpool.MinPoolSize=100 -Dweblogic.threadpool.MaxPoolSize=500

weblogic的http连接超时时间?

ueue: ‘billproxyqueue’ has been busy for “727″ seconds working on the request “Http Request: /bill/y

nQueryPublic.go”, which is more than the configured time (StuckThreadMaxTime) of “600″ seconds.>

一看明显是连接超时, 导致的错误.

1、程序问题,是不是程序中没有关闭连接

2、Configuration -》 Tuning -》 Stuck Thread Max Time: 600

如果程序没问题,则是weblogic的StuckThreadMaxTime设置过小而引起的,

一般weblogic server 的StuckThreadMaxTime默认参数是600s,即10分钟,如果并发量过大,

而导致等待处理过多,导致系统不停的增加线程,造成线程阻塞,

你可以把该参数设置大点这个是稍微调大StuckThreadMaxTime的参数即可.

3、看线程数设置,可适当增加线程数,这个在WLS控制台中可以调整

java程序模拟发起http请求到多渠道时,需要设置cookie值:

bke_isvr=dLpbR0XCzYryDZtPBhBLZwpQLn51sQ234hC1rlpqv6ThVJMJTK8W!1476132340

否则管理会将链接到sso时返回一个登陆页面给java模拟程序。

jsp文件,weblogic编译的servlet结果。

路径:项目/com/maps/index.jsp

编译好的路径:isvrDomain/servers/IsvrServer/tmp/_WL_user/isvr_mngApp/dioh2x/jsp_servlet/_com/_map

该servlet class的类名:out.println("========"+this.getClass().getName());

结果:========jsp_servlet._com._maps.__index

javac -verbose

java -verbose

DBPM服务端部在172.17.248.74 $HOME/shenlei/dbpm_j下

360在提交时会访问servlet两次:

https://172.17.248.181:7002/isvr/FileDownLoad?subjectId=080701&STAT_DT_STAT=20130617&STAT_DT_END=20130617

设置下载文件的大小:

response.setHeader("content-length", String.valueOf(filelen));

HTTP头的一些信息:

System.out.println("*******************************begin****************************************");

System.out.println("Protocol: " + request.getProtocol() );

System.out.println("Scheme: " + request.getScheme() );

System.out.println("Server Name: " + request.getServerName() );

System.out.println("Server Port: " + request.getServerPort() );

System.out.println("Protocol: " + request.getProtocol() );

System.out.println("Server Info: " + getServletConfig().getServletContext().getServerInfo());

System.out.println("Remote Addr: " + request.getRemoteAddr() );

System.out.println("Remote Host: " + request.getRemoteHost() );

System.out.println("Character Encoding: " + request.getCharacterEncoding() );

System.out.println("Content Length: " + request.getContentLength() );

System.out.println("Content Type: "+ request.getContentType() );

System.out.println("Auth Type: " + request.getAuthType() );

System.out.println("HTTP Method: " + request.getMethod() );

System.out.println("Path Info: " + request.getPathInfo() );

System.out.println("Path Trans: " + request.getPathTranslated() );

System.out.println("Query String: " + request.getQueryString() );

System.out.println("Remote User: " + request.getRemoteUser() );

System.out.println("Session Id: " + request.getRequestedSessionId() );

System.out.println("Request URI: " + request.getRequestURI() );

System.out.println("Servlet Path: " + request.getServletPath() );

System.out.println("Accept: " + request.getHeader("Accept"));

System.out.println("Host: " + request.getHeader("Host") );

System.out.println("Referer : " + request.getHeader("Referer") );

System.out.println("Accept-Language : " + request.getHeader("Accept-Language"));

System.out.println("Accept-Encoding : " + request.getHeader("Accept-Encoding") );

System.out.println("User-Agent : " + request.getHeader("User-Agent") );

System.out.println("Connection : " + request.getHeader("Connection") );

System.out.println("Cookie : " + request.getHeader("Cookie") );

System.out.println("Created : " + request.getSession().getCreationTime() );

System.out.println("LastAccessed : " + request.getSession().getLastAccessedTime() );